人工智能与自然语言处理发展史

多吃轻食 2024-10-18 17:01:02 阅读 83

前言

在科技的浪潮中,人工智能 (AI) 作为一股不可阻挡的力量,持续推动着社会与科技的进步。本博客旨在深入剖析人工智能及其核心领域——神经网络、自然语言处理、统计语言模型、以及大规模语言模型——的演进历程,以专业的视角展现这一领域的辉煌成就与未来展望。

人工智能的发展史,从早期的符号主义、连接主义到如今的深度学习,人工智能的每一次飞跃都离不开算法创新、计算能力提升及数据资源的丰富。神经网络作为人工智能的重要分支,其发展历程尤为引人注目。从最初的简单感知机到如今的深度神经网络,神经网络不仅在结构上变得更加复杂,还在性能上实现了质的飞跃,为人工智能的广泛应用奠定了坚实基础。

自然语言处理是人工智能的重要应用方向之一。从基于规则的语法分析到统计语言模型的广泛应用,再到深度学习在自然语言处理中的突破性进展,自然语言处理技术不断突破瓶颈,实现了从简单文本处理到复杂语义理解的跨越。统计语言模型作为自然语言处理的重要工具,其发展历程也是技术不断演进和优化的过程。

近年来,大规模语言模型的出现更是将人工智能推向了新的高度。通过在大规模数据集上进行预训练,大模型掌握了丰富的语言知识和常识推理能力,为自然语言理解、机器翻译、智能问答等多个领域带来了革命性的变化。大模型的成功应用,不仅展示了人工智能的无限潜力,也为未来的智能应用提供了广阔的想象空间。

本博客将逐一梳理这些领域的发展历程,探讨关键技术的演进轨迹,分析成功案例的背后逻辑,并展望未来的发展趋势。

文章目录

前言1.人工智能发展史1.1推理期1.2知识期1.3学习期1.4总结

2.神经网络的发展史2.1模型提出2.2冰河期2.3反向传播算法引起的复兴2.4流行度降低在这里插入图片描述2.5深度学习的崛起

3.NLP的发展历史3.1起源3.2基于规则3.3基于统计3.4深度学习和大数据驱动

4.统计语言模型的发展历程4.1N-Gram模型4.2Bag-of-Words模型4.3分布式表示4.4神经概率语言模型4.5Word2Vec4.6预训练语言模型

5.大模型时代的发展历史5.1基础模型阶段5.2能力探索阶段5.3突破发展阶段

结尾参考资料

1.人工智能发展史

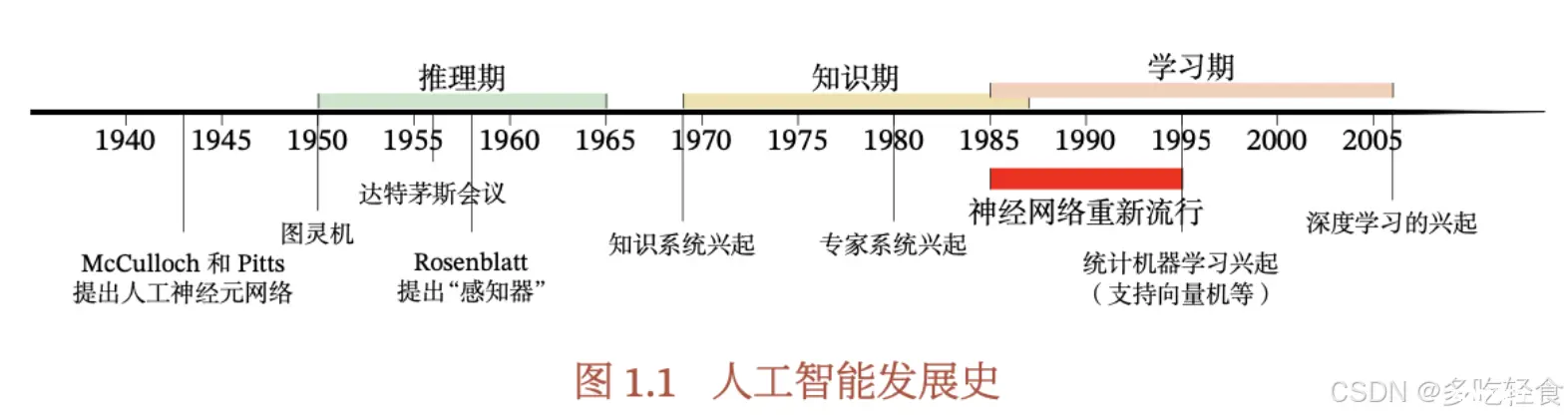

以上是人工智能的发展史,大致脉络可以分为大致三个阶段:推理期、知识期和学习期,每一阶段都标志着该领域显著的进步与转型。

1.1推理期

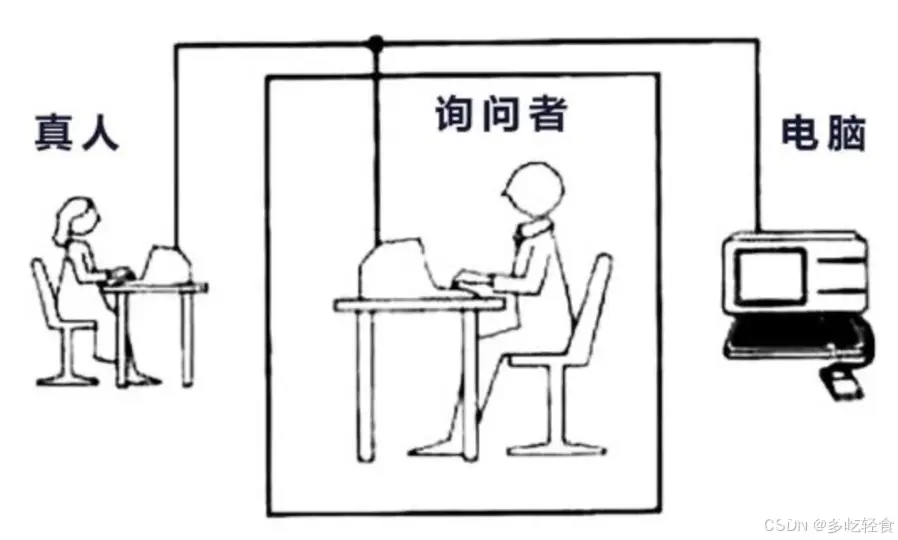

1950年,图灵(Alan Turing) 的论文*《计算机器与智能》中提出了一个讨论,讨论了创造一种“智能机器的可能性”。这个测试就是著名的图灵测试:“一个人在不接触对方的情况下,通过一种特殊的方式和对方进行一系列问答。如果在相当长的时间内,他无法根据这些问题判断对方是人还是计算机,那么就可以认为这个计算机是智能的。”*

图灵测试是测试人工智能从哲学讨论到科学研究的一个重要因素,引导了人工智能的很多研究方向。在他定的大方向下,计算机要通过图灵测试,就必须要具备理解语言、学习、记忆、推理、决策的能力。

这样人工智能就延伸出了很多不同的字学科,比如机器感知(CV,语言信息处理)、学习(模式识别,机器学习,强化学习)、语言(NLP)、记忆(知识表示)、决策(规划、数据挖掘)等。以上都可以认为是人工智能的研究范畴。

图灵的工作通常被认为是现代人工智能的起点之一,因为他从理论上探讨了机器智能的可能性。

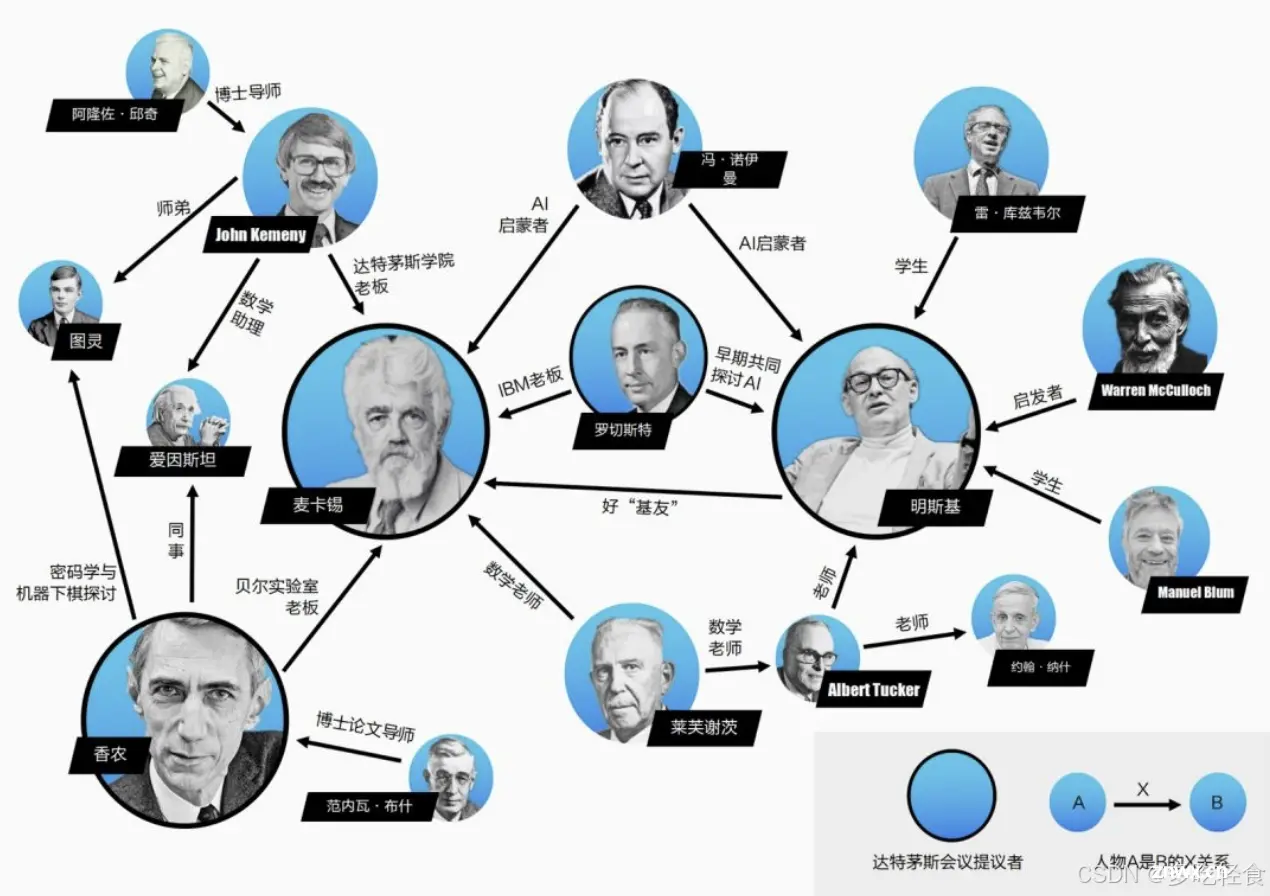

1956年达特茅斯会议(Dartmouth),是人工智能领域的又一个重要的里程碑,标志着人工智能正式作为一个独立的学科诞生。会议由约翰·麦卡锡(John McCarthy)和马文·明斯基(Marvin Minsky)组织,旨在探索机器模拟智能的可能性。(香农也在这次会议中)

约翰·麦卡锡提出了人工智能的定义:人工智能就是要让机器的行为看起来就像是人所表现出的智能行为一样。

该会议之后的十几年,被公认为是人工智能领域的黄金时期。在这一阶段,众多早期的研究者们纷纷投身于这一新兴领域,致力于通过逻辑演绎或事实归纳,提炼出一系列精妙的规则,以期为机器赋予智能。

然而,当时的研究者们对人工智能的发展前景持有过于乐观的态度。他们满怀信心地预言:“在未来的20年内,机器将能够胜任人类所能完成的一切工作。”这一宏伟的愿景,无疑激发了人们对人工智能的无限遐想与期待。

随着研究的不断深入,研究者们逐渐发现,这些基于简单逻辑和事实归纳的推理规则,在面对复杂多变的现实世界时,显得过于简陋和片面。这一发现,无疑给原本乐观的预期泼了一盆冷水,使得人工智能的研究陷入了前所未有的低谷。在这一困境中,许多项目的研究经费被大幅削减,人工智能领域的发展步伐也因此变得缓慢而艰难。然而,正是这些挫折与困境,促使研究者们开始重新审视和思考人工智能的发展方向与路径,为后续的突破与崛起奠定了坚实的基础。

1.2知识期

到了20世纪七十年代,研究者意识到了知识对于人工智能系统的重要性,特别是对于一些复杂的任务,需要专家来构建知识库。

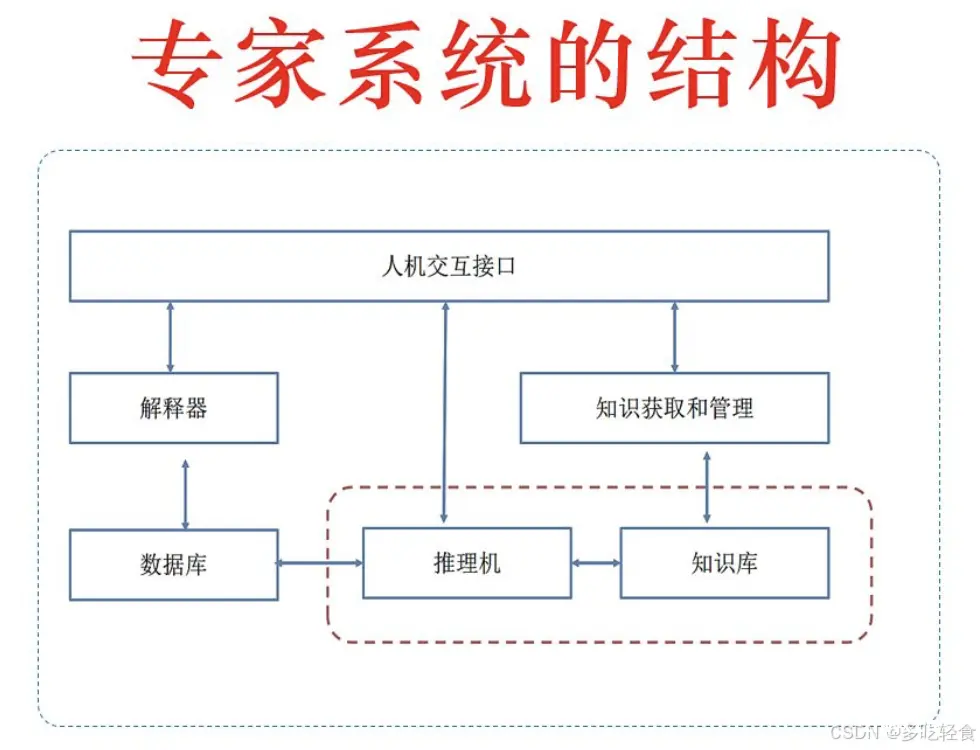

这一时期出现了各种各样的专家系统(Exper System),并在特定的领域取得了很多成果。

专家系统可以简单理解为“知识库+推理机”,是一类具有专门的知识和经验的计算机智能程序系统。专家系统一般采用知识表示和知识推理等技术来完成通常由领域专家才能解决的问题,因此也被称为基于知识的系统。

一个专家系统必须具备三要素:

1)领域专家知识;2)模拟专家思维;3)达到专家级水平

1.3学习期

图中的最后阶段,1985年随着神经网络的崛起(反向传播算法应用到了神经网络中),人工智能步入了学习期。对于人类的很多智能行为,我们很难知道其中的原理,也无法描述智能行为背后的“知识”。因此,研究者开始将研究重点转向让计算机从数据中自己学习。

机器学习(Machine Learning,ML)就是这样的方法。他的主要目的是设计和分析一些学习算法,让计算机可以从数据(经验)中自动分析并获得规律,之后利用学习到的规律对未知数据进行预测,从而帮助人们完成一些特定任务。

1.4总结

在人工智能发展了60多年后,机器虽然可以在某些方面超越人类,但想让机器真正通过图灵测试,具备真正意义上的人类智能,这个目标看上去仍然遥遥无期。

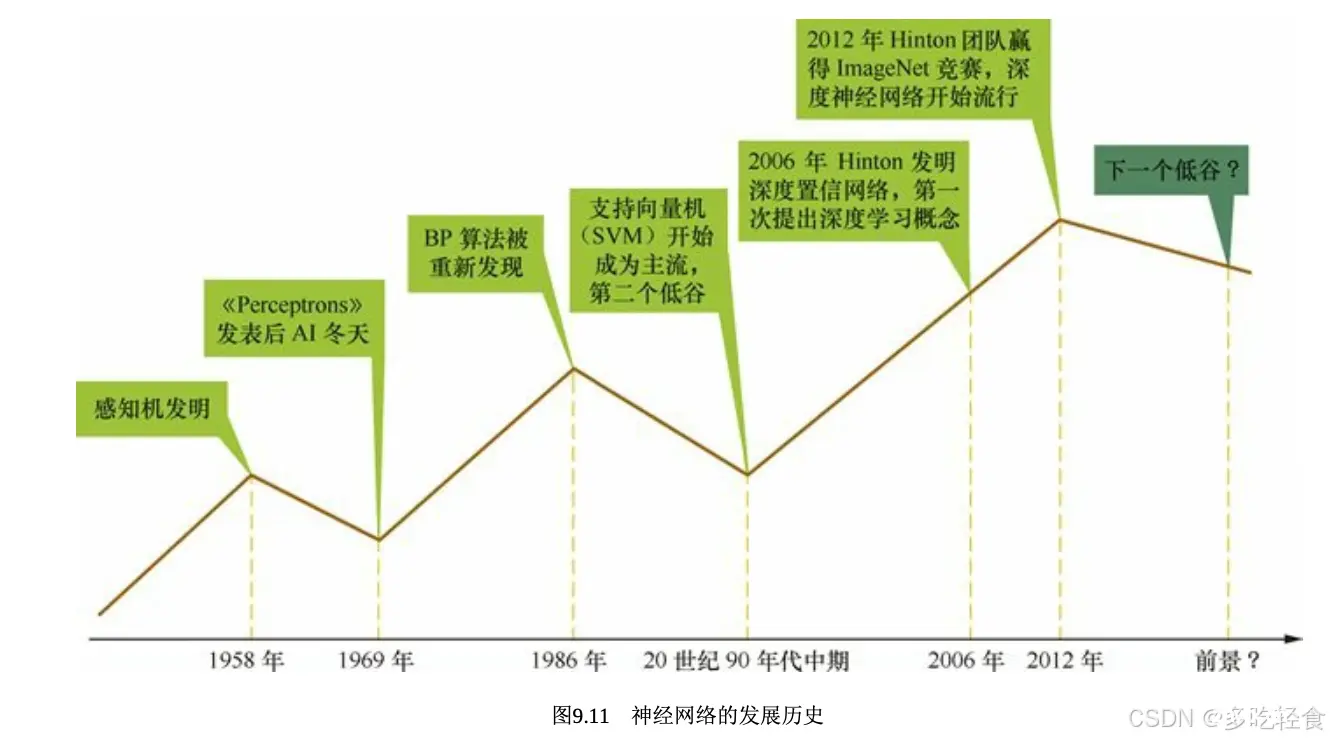

2.神经网络的发展史

回顾历史,今天遍布开花的神经网络,并不是最近冒出来的新鲜玩意,而是名副其实的老古董。神经网络的发展大致经过以上五个阶段。

2.1模型提出

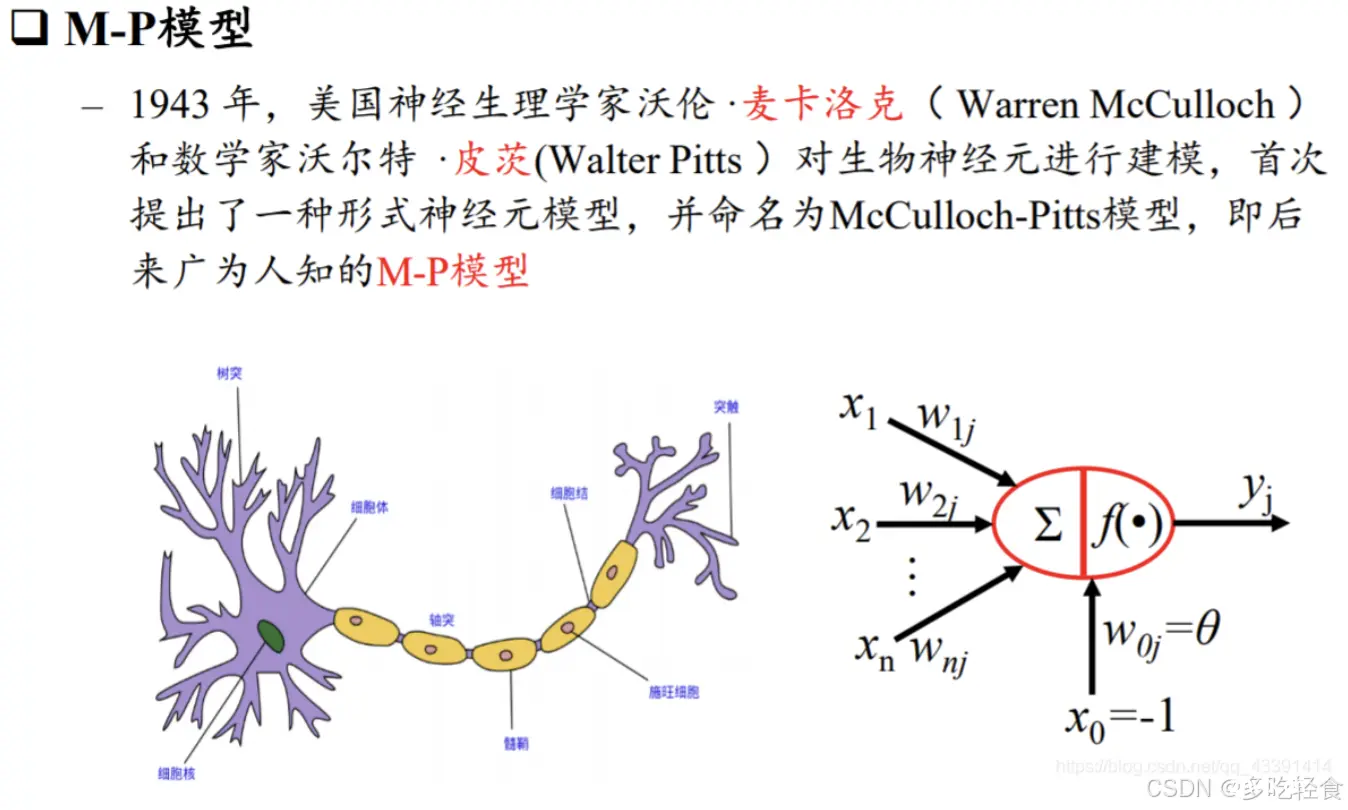

第一阶段为1943年~1969年,这是神经网络发展的第一个高潮。

在1943年,沃伦·麦卡洛克(Warren McCulloch) 和 沃尔特·皮茨(Walter Pitts) 在1943年发表了一篇论文,提出了人工神经网络的概念。这一工作实际上是在研究生物神经系统的基础上,构建出了一种可以进行逻辑计算的数学模型,称为“麦卡洛克-皮茨神经元(MP模型)”,它描述了简单神经元的工作方式。这个模型被认为是人工神经网络的雏形。

1948年,阿兰·图灵提出了一种“B型图灵机”,他可以基于Hebbian法则(简单来说就是,神经元同时活动,则它们的连接就会加强)来进行学习。

1951年,沃伦·麦卡洛克(Warren McCulloch) 和 沃尔特·皮茨(Walter Pitts)的学生 马文·明斯基(Marvin Minsky) 建造了第一台神经网络机SNARC。

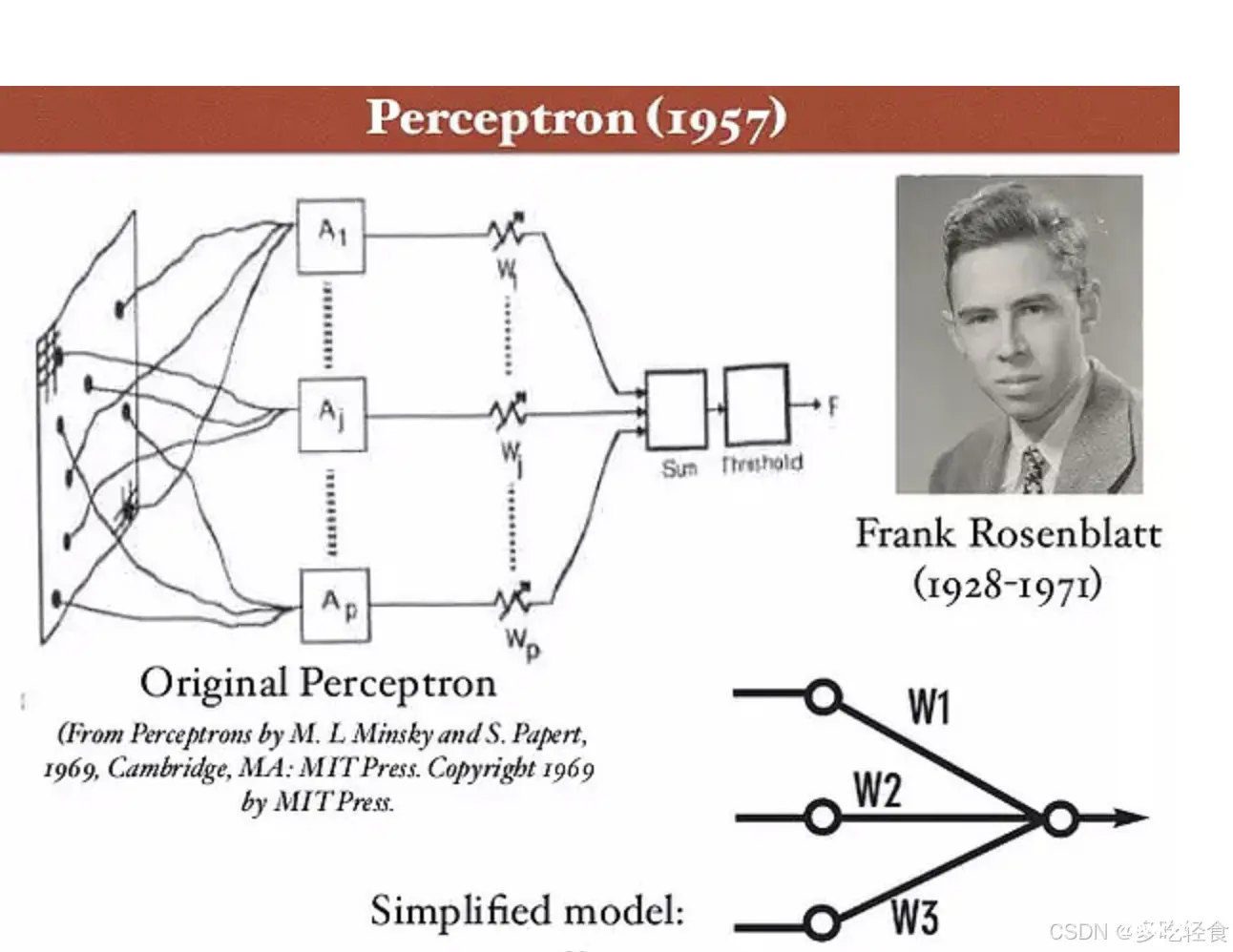

1958年,弗兰克·罗森布拉特(Frank Rosenblatt)发明了感知机,它是一种基于生物学神经元的简单模型。感知机提出了一种接近于人类学习过程的学习方法(迭代、试错),被认为是神经网络历史上的一个重要里程碑。

以上的工作为后续的人工智能和神经网络研究奠定了坚实的基础。在此之后,研究者们深受启发,纷纷投入到神经网络的研究中,推动了该领域的快速发展。

2.2冰河期

第二阶段为 1969 年~1983 年,是神经网络发展的第一个低谷期。

在此期间,神经网络的研究处于长年停滞及低潮状态。

1969 年,Marvin Minsky 出版《感知机》 一书,指出了神经网络的两个关键缺陷:一是感知机无法处理“异或”回路问题;二是当时的计算机无法支持处理大型神经网络所需要的计算能力。

异或(XOR)问题:异或是一个逻辑运算,当两个输入不同时输出为1,相同时输出为0。这个问题对于单层感知机来说是无法解决的,因为单层感知机只能解决线性可分问题,而异或问题是一个典型的线性不可分问题。

此外,当时的算力和现在的算力可能相差数百万倍

这些论断使得人们对以感知机为代表的神经网络产生质疑,并导致神经网络的研究进入了十多年的“冰河期”.

但是这一时期仍然有不少学者提出了很多有用的模型或算法。

1974年,Paul Werbos 在神经网络领域取得了突破性进展,他发明了反向传播算法(BackPropagation,简称BP)。这一算法对于神经网络的学习和训练具有至关重要的意义,它能够有效地调整网络中的权重,从而提高网络的预测准确性。然而,遗憾的是,在当时,这一重要发明并未获得应有的重视和认可,其潜在价值被大大低估。

到了1980年,福岛邦彦又提出了一种全新的多层神经网络模型——新知机(Neocognitron)。这一模型巧妙地融入了卷积和子采样操作,为图像处理等任务提供了有力的支持。然而,由于它采用的是无监督学习的方式来进行训练,并未采用当时尚未被广泛认知的反向传播算法,因此,新知机在提出之初也并未引起学术界的足够重视。

尽管如此,这些先驱者的贡献为后来的神经网络发展奠定了坚实的基础,他们的创新精神和远见卓识在神经网络的历史上留下了深刻的印记。

2.3反向传播算法引起的复兴

第三阶段为 1983 年~1995年,是神经网络发展的第二个高潮期。

这个时期中,反向传播算法重新激发了人们对神经网络的兴趣.

1983 年,物理学家约翰·霍普菲尔德(John Hopfield)提出了一种用于联想记忆(Associative Memory)的神经网络,称为Hopfield网络.

Hopfield网络在旅行商问题上取得了当时最好结果,并引起了轰动.

旅行商问题(Traveling Salesman Problem, TSP)是一个经典的组合优化问题,它属于NP-hard问题范畴。具体来说,旅行商问题涉及到一个旅行商(或推销员)需要拜访n个城市,每个城市只能拜访一次,最后回到出发的城市,且要求总的旅行距离最短。对于每一对城市i和j,都有一个距离或成本d(i, j)表示从城市i到城市j的旅行距离。旅行商的目标是找到一条路径,使得他能够按照这个规则遍历所有城市,并且总的旅行距离最短。

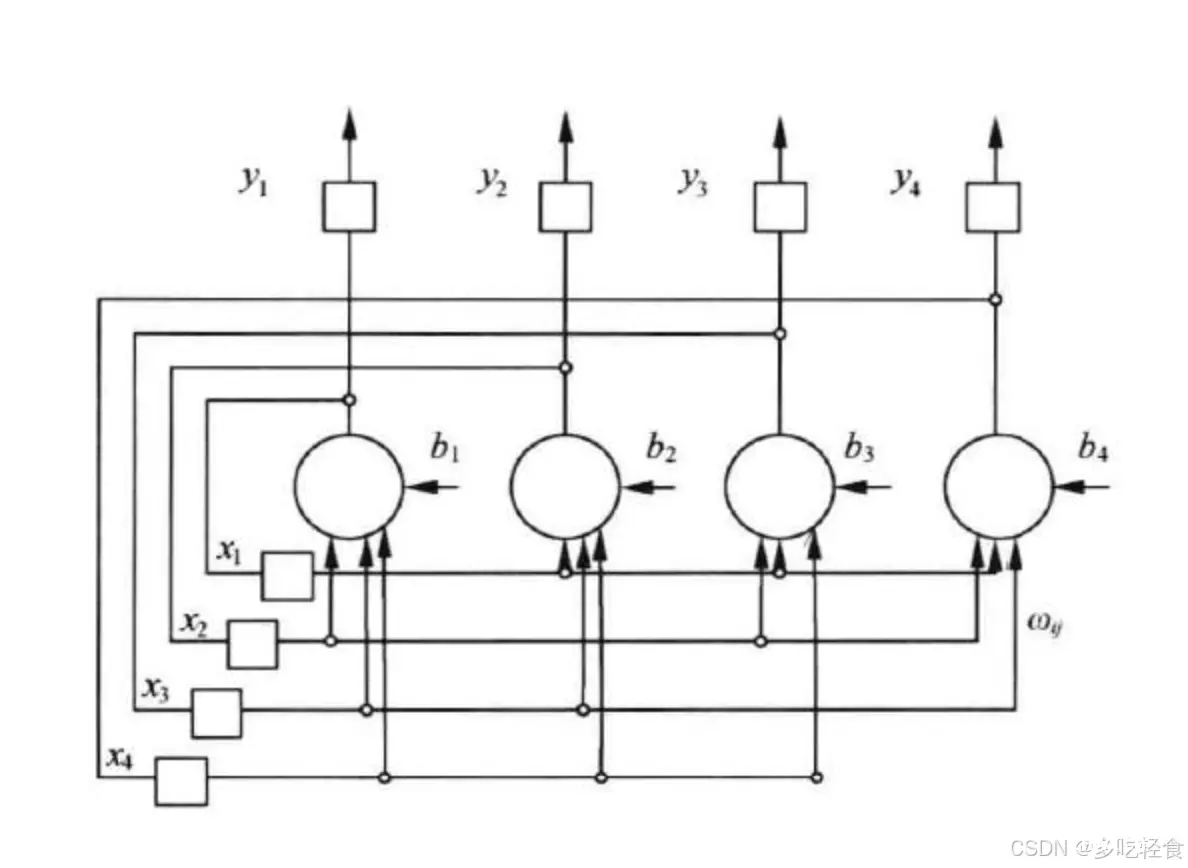

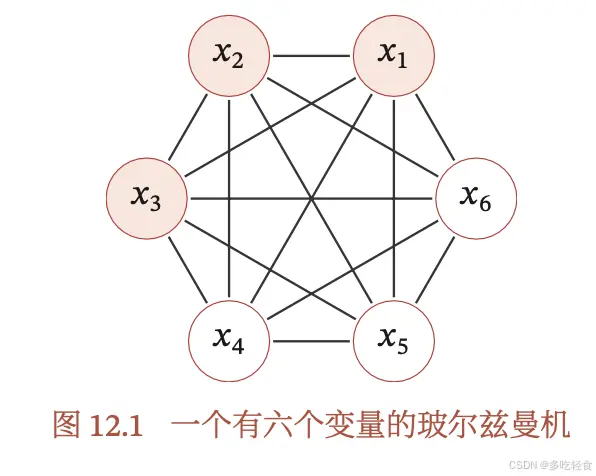

1984年,杰弗里·辛顿(Geoffrey Hinton) 提出一种随机化版本的Hopfield 网络,即玻尔兹曼机(Boltzmann Machine).

真正引起神经网络第二次研究高潮的是反向传播算法.

20世纪80年代中期,一种连接主义(还有两个主义是符号主义和行为主义)模型开始流行,即分布式并行处理(Parallel Distributed Processing,PDP)模型.反向传播算法也逐渐成为PDP模型的主要学习算法.

这时,神经网络才又开始引起人们的注意,并重新成为新的研究热点.

符号主义是人工智能的先驱流派,它主张通过符号逻辑推理实现人工智能。这一学派认为,人类思维和认知过程可以通过符号系统来模拟,计算机可以像人一样进行符号操作,从而实现智能行为。符号主义注重知识表示和推理,广泛应用于专家系统、自然语言处理等领域。其优点在于逻辑规则的清晰和易解释性,但处理模糊和不确定性问题时存在局限。连接主义,又称仿生学派或生理学派,主张通过模拟神经元之间的相互连接和权值来实现人工智能。它强调从大量数据中学习并优化网络连接,以实现智能行为。深度学习作为连接主义的一个重要分支,在图像识别、语音识别等领域取得了巨大成功。连接主义具有模拟人脑处理信息的能力,但网络训练需要大量时间和计算资源,且结果缺乏可解释性。行为主义强调对行为和反馈的研究,认为人工智能应该基于感知和行动,让机器在与环境的交互中学习并优化行为。这一学派广泛应用于机器人控制、自动驾驶等领域。行为主义注重实时响应和适应性,通过试错学习和奖惩机制来优化行为策略。然而,它也需要大量的数据和运算支持,且应用范围相对较窄。

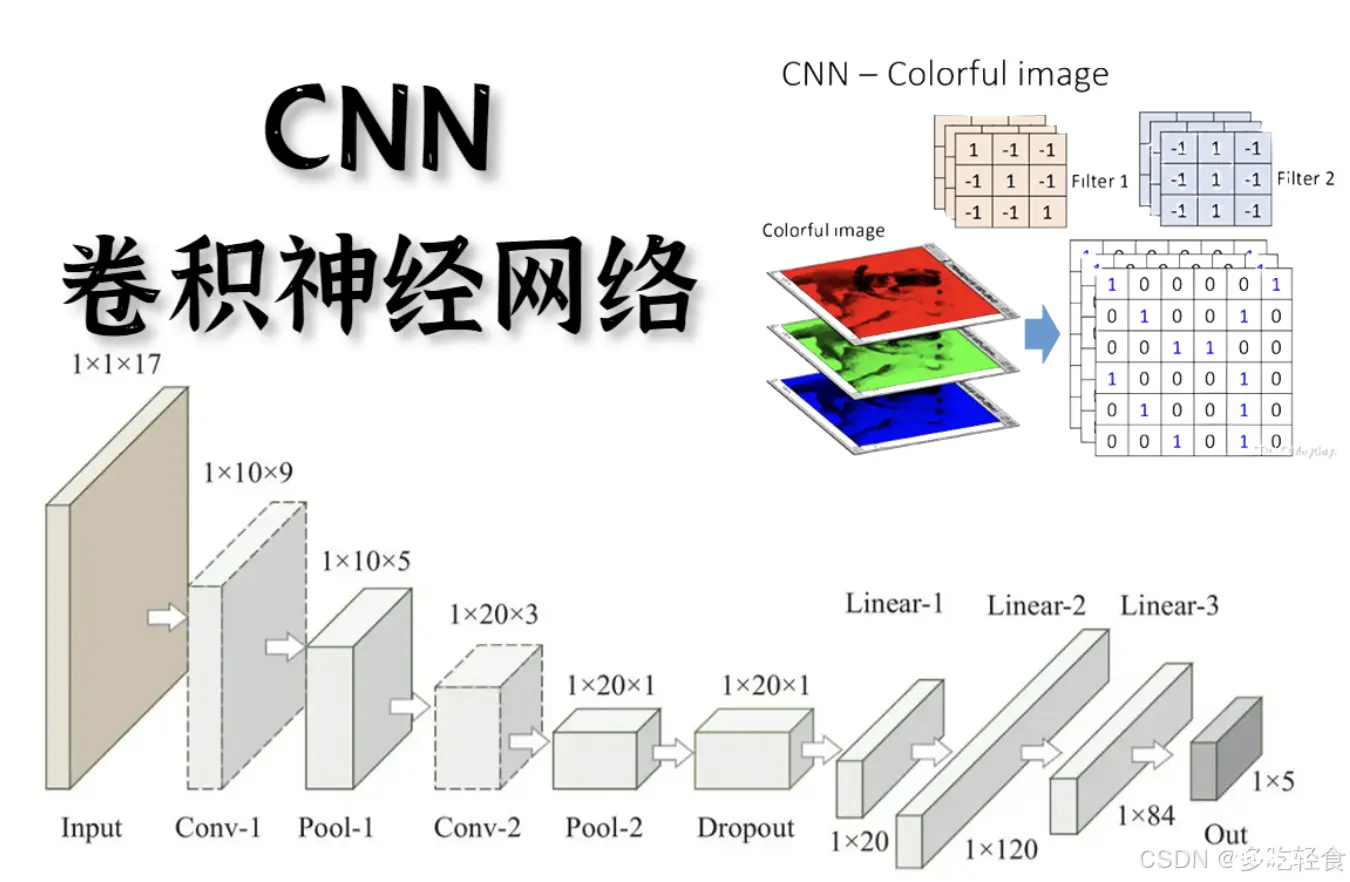

随后,将反向传播算法引入了卷积神经网络,并在手写体数字识别上取得了很大的成功.

反向传播算法可以说是迄今最为成功的神经网络学习算法.

目前在深度学习中主要使用的自动微分可以看作反向传播算法的一种扩展.

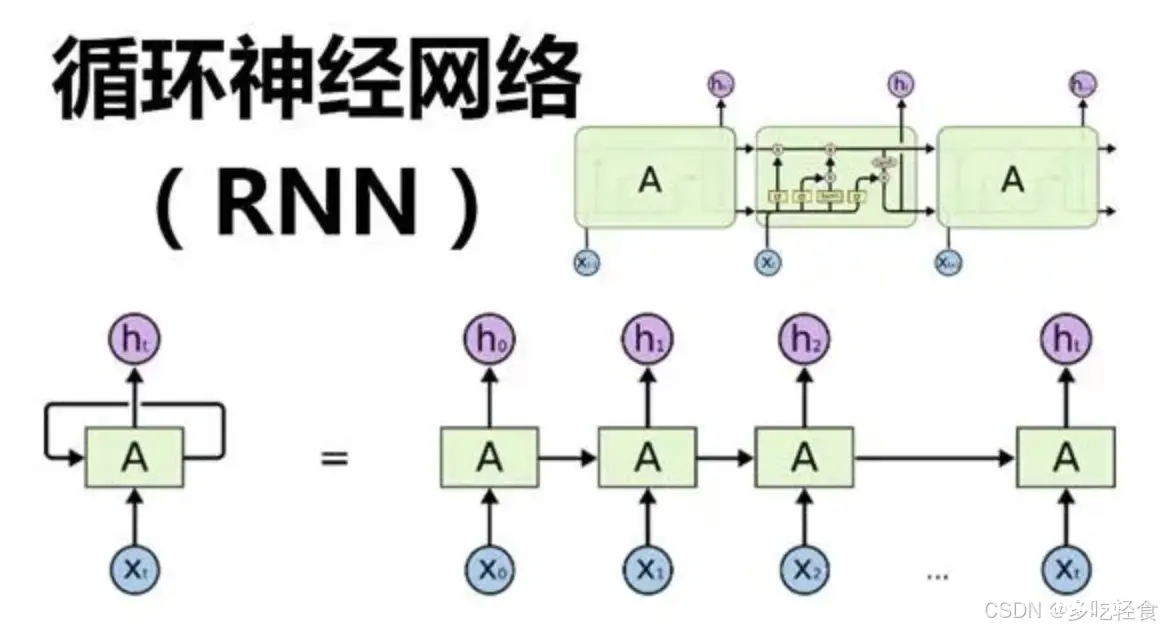

然而,梯度消失问题(Vanishing Gradient Problem)阻碍神经网络的进一步发展,特别是循环神经网络.

为了解决这个问题,采用两步来训练一个多层的循环神经网络:

1)通过无监督学习的方式来逐层训练每一层循环神经网络,即预测下一个输入;22)通过反向传播算法进行精调

2.4流行度降低

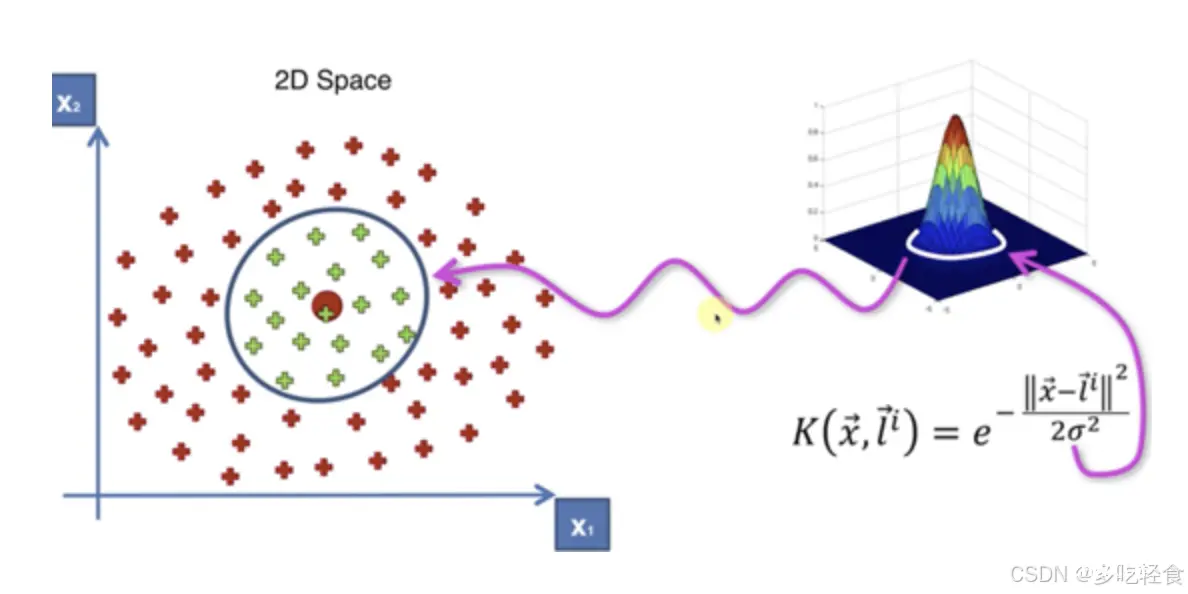

第四阶段为1995年~2006年,在此期间,支持向量机(下图为高斯核函数的SVM)和其他更简单的方法(例如线性分类器)在机器学习领域的流行度逐渐超过了神经网络。

虽然神经网络可以很容易地增加层数、神经元数量,从而构建复杂的网络,但其计算复杂性也会随之增长,而且当时的计算机性能和数据规模不足以支持训练大规模神经网络。

杂谈1–>杨立昆和他的一生之敌

LeCun Yann(他给自己起了个洋气的名字:杨立昆)和其他人发展的神经网络正开始被热捧的时候,他一生较劲的对象万普尼克(Vapnik)(贝尔实验室的同事)出现了。20世纪90年代中期,由 Vapnik 等人发明的支持向量机诞生,它同样解决了线性不可分问题,但是对比神经网络有全方位优势。

比如,高效、可以快速训练;无须调参,没有梯度消失问题;泛化性能好,过拟合风险小。

支持向量机迅速打败多层神经网络成为主流。后来一度发展到,只要你的论文中包含神经网络相关的字眼,就非常容易被拒稿,学术界那时对神经网络的态度可想而知。神经网络再次堕入黑暗。10年沉寂中,只有几个学者仍然在坚持研究,比如一再提及的Hinton 教授。

杂谈2–>现代人工智能三驾马车

杨立昆(Yann LeCun)、杰弗里·辛顿(Geoffrey Hinton)和约书亚·本希奥(Yoshua Bengio)。

杨立昆:

纽约大学教授,Facebook AI研究院的首席AI科学家。

主要贡献在于卷积神经网络(CNN),这种网络在计算机视觉任务中得到了广泛应用。

开发了 LeNet,这是一种用于手写数字识别的早期卷积神经网络。

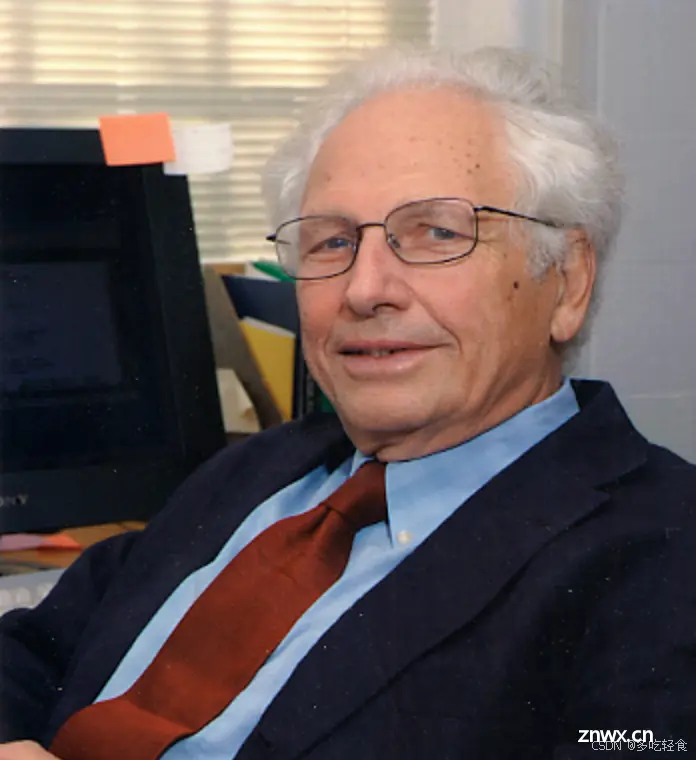

杰弗里·辛顿:

多伦多大学教授,谷歌大脑团队的成员。

被誉为“深度学习之父”,在反向传播算法和深度神经网络的研究方面做出了重大贡献。

他的工作推动了深度学习在语音识别、图像处理和自然语言处理中的应用。

我们学过的RMSprop也是他发明的

约书亚·本希奥(Yoshua Bengio):

蒙特利尔大学教授,Mila(蒙特利尔学习算法研究所)的创始人之一。

他的研究涵盖深度学习的各个方面,特别是在生成模型和序列模型方面的工作。

生成模型:在变分自编码器(VAE)和生成对抗网络(GAN)方面做出了重要贡献。

序列模型:改进了递归神经网络(RNN)和长短期记忆网络(LSTM),提升了处理时间序列数据的能力。

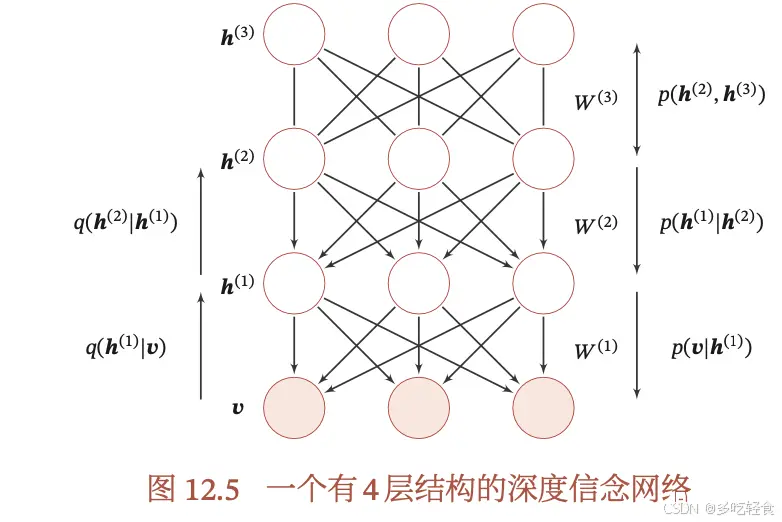

深度学习算法:开发和推广了卷积神经网络(CNN)和深度信念网络(DBN)。

杂谈3–>杰弗里·辛顿的传奇人生

辛顿出生在英国,母亲是数学老师,父亲是昆虫学家,“国民生产总值”这个术语是他的经济学家舅舅发明的,他的高曾祖父是现代计算科学的基础布尔代数的发明人。

后来他们搬家到了布里斯托,进入了克利夫顿学院(其实是顶尖私立学校),可在他口中却是一个“二流公立学校”。

高中毕业后,辛顿去了剑桥大学学习了物理和化学,但是只读了一个月就退学了。

一年后,他有重新申请了剑桥大学并转学建筑,结果坚持一天就退学了。

然后又转向了物理学和生物学,但是后来发现物理中的数学太难了。因此又转学了哲学,花了一年修完了两年的课程。

辛顿说:“这一年大有裨益,因为我对哲学产生了强烈的抗体,我想要理解人类意识的工作原理。”

于是,他又又又又转向了心理学,仅仅为了肯定“心理学家对人类的意识也不明所以”。

在1973年前往爱丁堡大学研究生学院学习人工智能之前,他做了一年的木匠。

即使在当时,辛顿已经确信不被看好的神经网络才是正确之路,但是他的导师却在那时候刚改为支持人工智能的传统论点。

辛顿说:“我的研究生生涯充满了暴风骤雨,每周我和我的导师都会有一次争吵。我一直在做着交易,我会说,好吧,让我再做6个月时间的神经网络,我会证明他的有效性的。当六个月的时间结束了,我又说,我几乎要成功了,再给我6个月。自此之后我一直说,再给我五年时间,而其他人也一直说,你做这个都5年了,他永远不会有效的。但终于,神经网络奏效了”

2.5深度学习的崛起

第五阶段为从 2006 年开始至今,在这一时期研究者逐渐掌握了训练深层神经网络的方法,使得神经网络重新崛起.

2006年,Hinton通过逐层预训练来学习一个深度信念网络,并将其权重作为一个多层前馈神经网络的初始化权重,再用反向传播算法进行精调.这种“预训练+精调”的方式可以有效地解决深度神经网络难以训练的问题.

(结构和全连接神经网络很像)

他给多层神经网络相关的学习方法赋予了一个新名词–“深度学习”。

随着深度神经网络在语音识别和图像分类等任务上的巨大成功,以神经网络为基础的深度学习迅速崛起.

近年来,随着大规模并行计算以及GPU设备的普及,计算机的计算能力得以大幅提高.此外,可供机器学习的数据规模也越来越大.

在强大的计算能力和海量的数据规模支持下,计算机已经可以端到端地训练(直接优化任务的总体目标,不分模块分阶段的训练,神经网络就是端到端的训练)一个大规模神经网络,不再需要借助预训练的方式.各大科技公司都投入巨资研究深度学习,神经网络迎来第三次高潮。

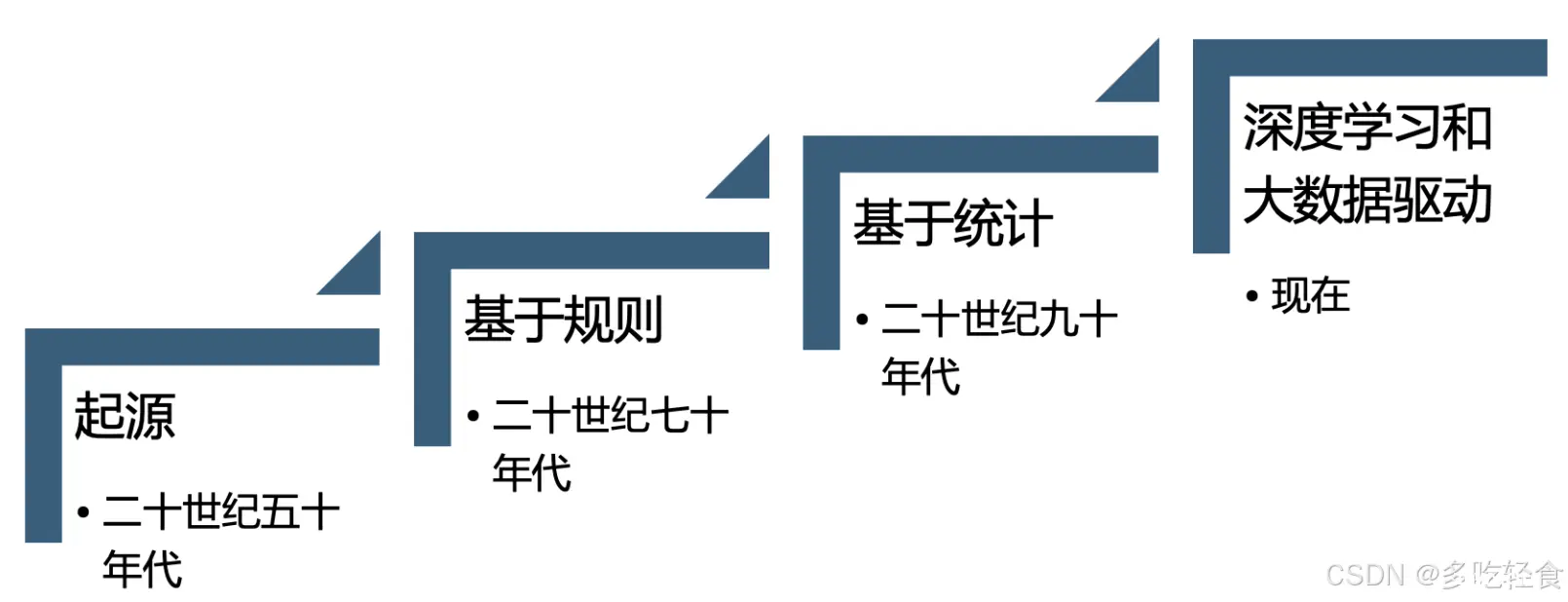

3.NLP的发展历史

在过去的几十年里,计算机科学领域经历了一场巨大的变革,其中自然语言理解(NLP)作为一门重要的研究方向,见证了从萌芽到蓬勃发展的辉煌历程。

从早期的基于规则的方法,到现在以深度学习为核心的模型,NLP的发展离不开科技的进步和学术界的不断探索。

3.1起源

NLP的思想可以追溯到阿兰·图灵当是提出的图灵测试:通过与人类进行对话,来测试机器是否具有智能。如果机器能够让人类无法分辨它是机器还是真人,那么它就通过了图灵测试,被认为具有智能。

3.2基于规则

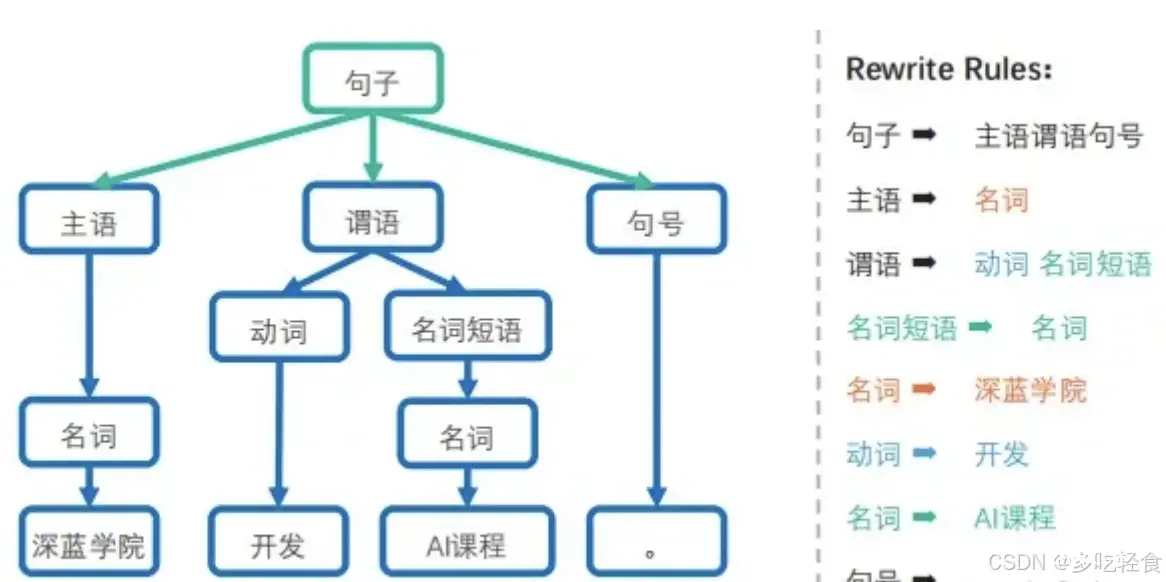

随后的数十年中,人们尝试通过基于语法和语义规则的方法解决NLP领域的问题。但是人类的语言十分之多,据统计人类大概有7000多种语言,他们的语义规则又各不相同。所以这种方法几乎不可能涵盖所有的语言。

3.3基于统计

弗雷德里克·贾利尼克教授(Frederick Jelinek)等大牛们,在当时采用了一种基于统计方法的方法解决语音识别的问题,这样把一个基于规则的问题转换成了基于统计的数学问题,这样NLP任务的准确率有了质的飞跃。

贾利尼克等人提出的这个框架对语音和语言处理领域产生了深远的影响,从根本上使得语音识别技术有了实用的可能性。此外,他曾担任约翰霍普金斯语言与语音处理中心主任,在该中心培育了很多华人校友,比如吴军博士等人。

从这个时候起,人们通过基于统计的方法定义了语言模型这个概念。(语言模型:基于统计方法,通过计算给定文本序列的概率分布来预测或生成文本)

3.4深度学习和大数据驱动

进入21世纪后,深度学习和大数据的结合推动了NLP的发展。随着计算能力的提升和大规模语料库的出现,深度学习模型在多个NLP任务中取得了突破性进展。

卷积神经网络(CNN):虽然CNN主要用于图像处理,但也被应用于文本分类和情感分析等NLP任务。

递归神经网络(RNN):RNN及其变体(如LSTM和GRU)在机器翻译、语言建模和文本生成等任务中取得了显著成果。

Attention机制:2015年,Bahdanau等人提出了注意力机制,使得模型可以在编码过程中关注输入序列的不同部分,提高了机器翻译的效果。

4.统计语言模型的发展历程

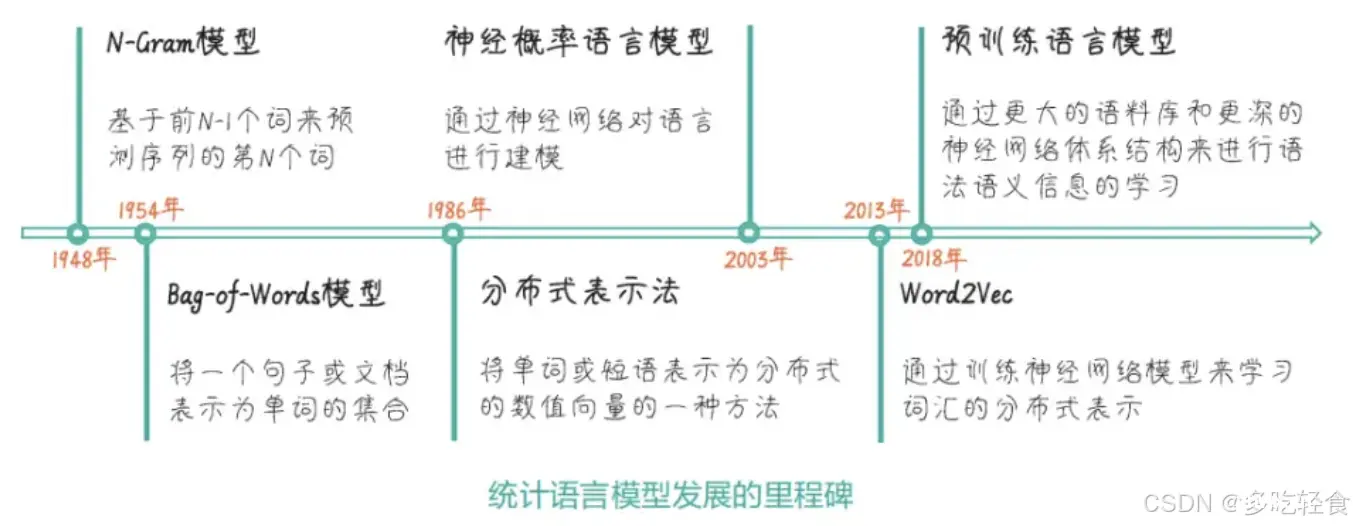

其实基于统计的语言模型其实出现的也很早,他的发展历程和AI技术也很类似。虽然有理论,但是早起的网络结构和数据量的局限,早起的统计语言模型并没有突破性的应用。

以上是统计语言模型发展的里程碑。其中上半部分是语言模型的技术进展,下半部分是词向量的技术进展。

这里把统计语言模型单独拿了出来讲,是因为它在NLP领域中的基础性和重要性,对后续技术的发展起了相当重要的铺垫作用,为后来的技术发展提供了宝贵的经验和支持,是NLP历史中不可或缺的一部分。

4.1N-Gram模型

1948年N-Gram模型诞生,思路是基于前N-1个项目来预测序列的第N个项目,所谓的项目就是词或短语。

4.2Bag-of-Words模型

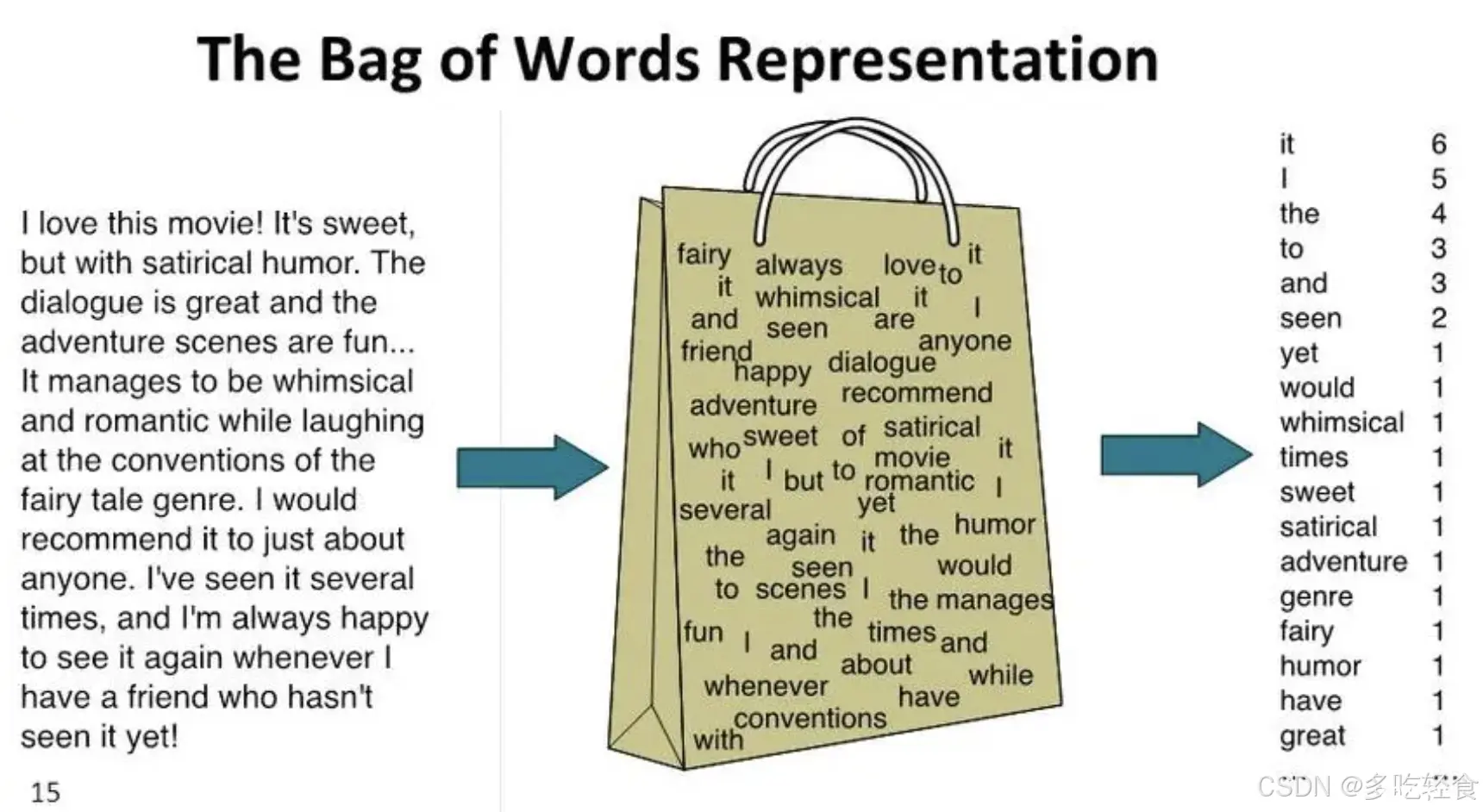

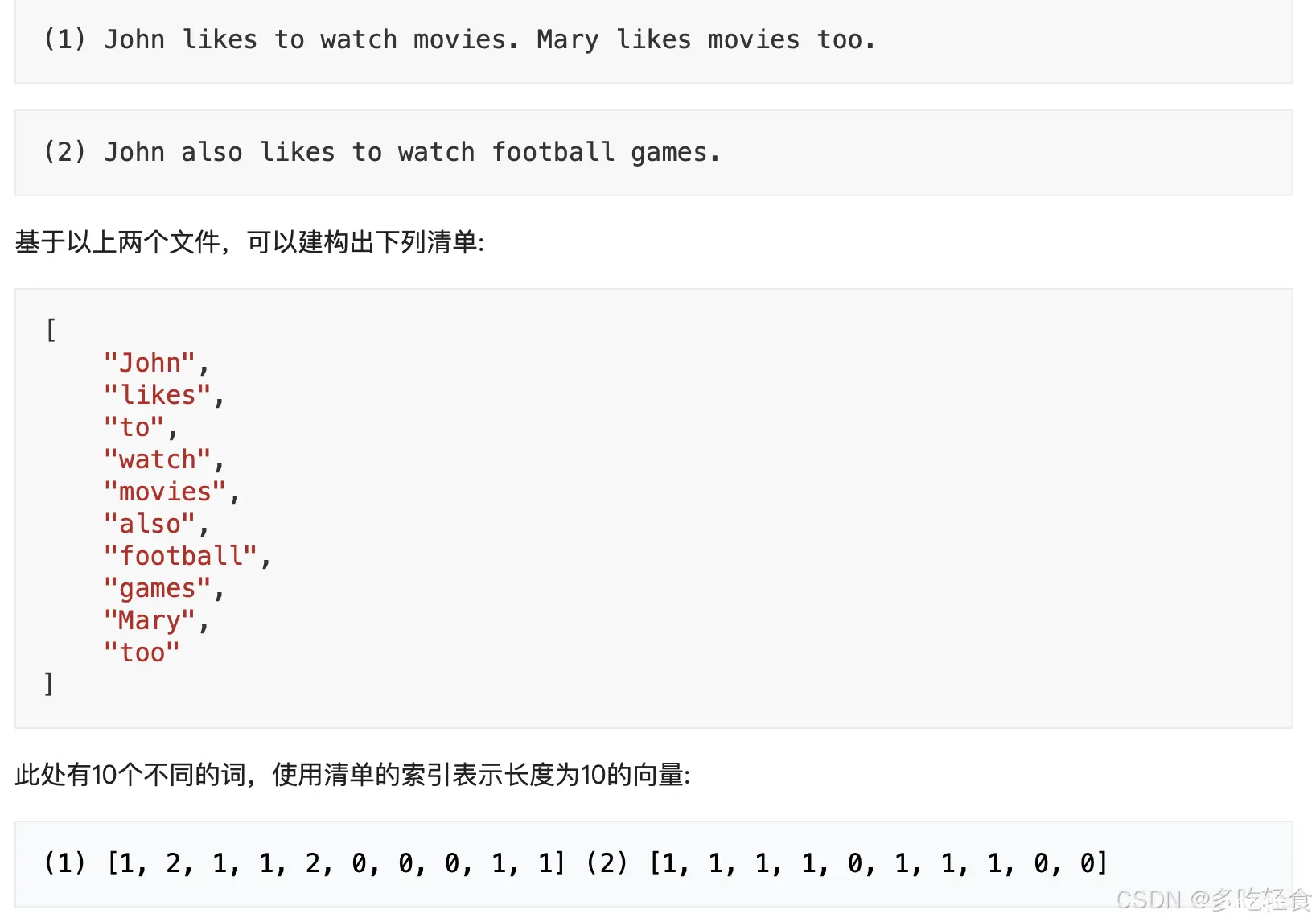

1954年的词袋模型是一种简单且常用的文本表示方法,他将文本表示为一个单词的集合,不考虑单词在文本中的顺序。

这种表示方法中,每个单词都可以表示为一个单词的频率向量,对应一个特定的维度,向量的值表示在文本中出现的次数。如下:

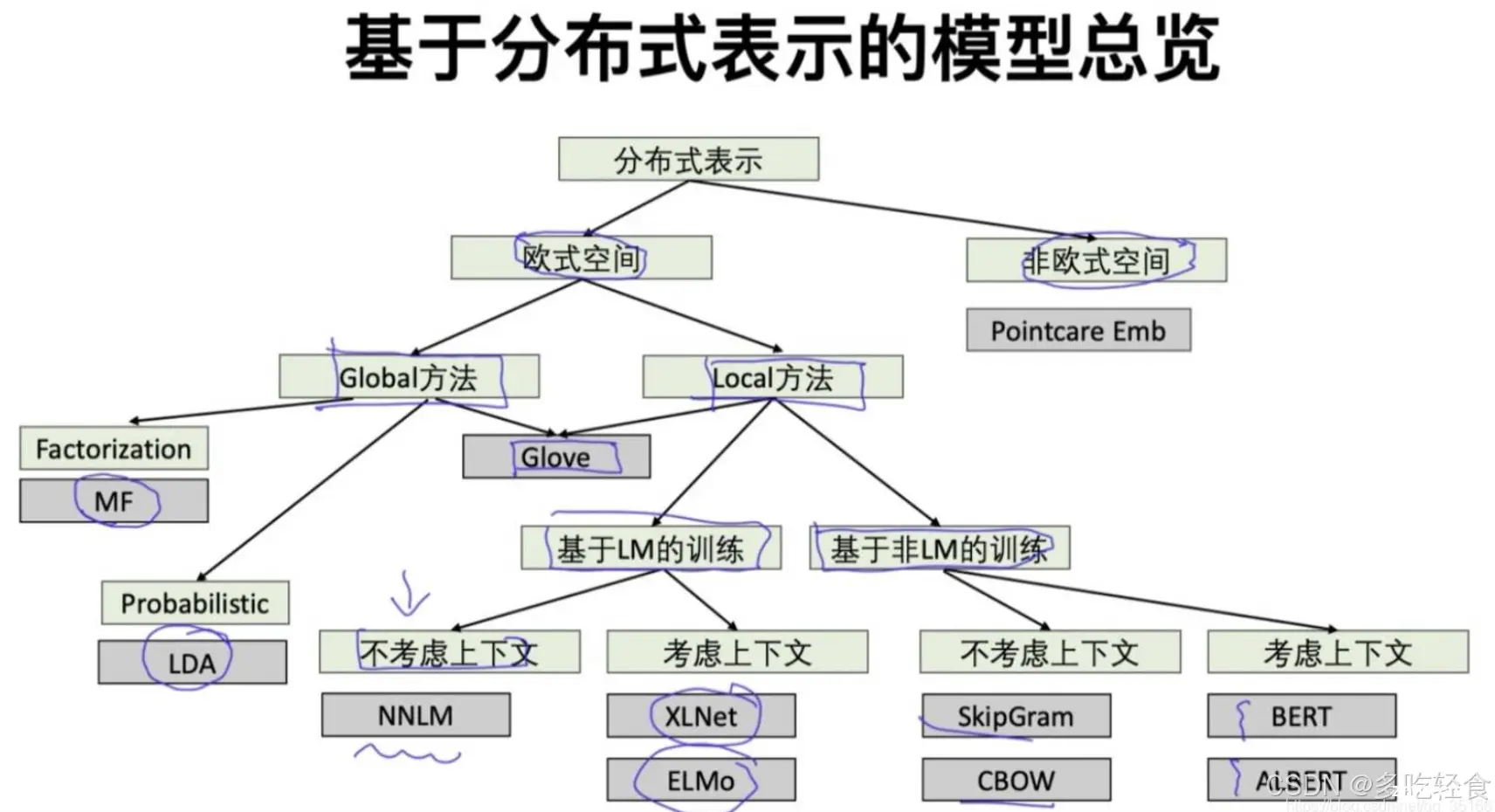

4.3分布式表示

1986年的分布式表示是一种将词或短语表示为数值向量的方法。这种表示方法中,单词的语义信息被分散到向量的各个维度上,因此可以捕捉单词之间的相似性和关联性。

分布式表示主要基于单词在文本中的上下文来构建,因此有较多的语义和句法信息。

这种表示有助于解决传统的词袋模型和one hot编码中的词汇鸿沟问题(歧义,同义词)。

4.4神经概率语言模型

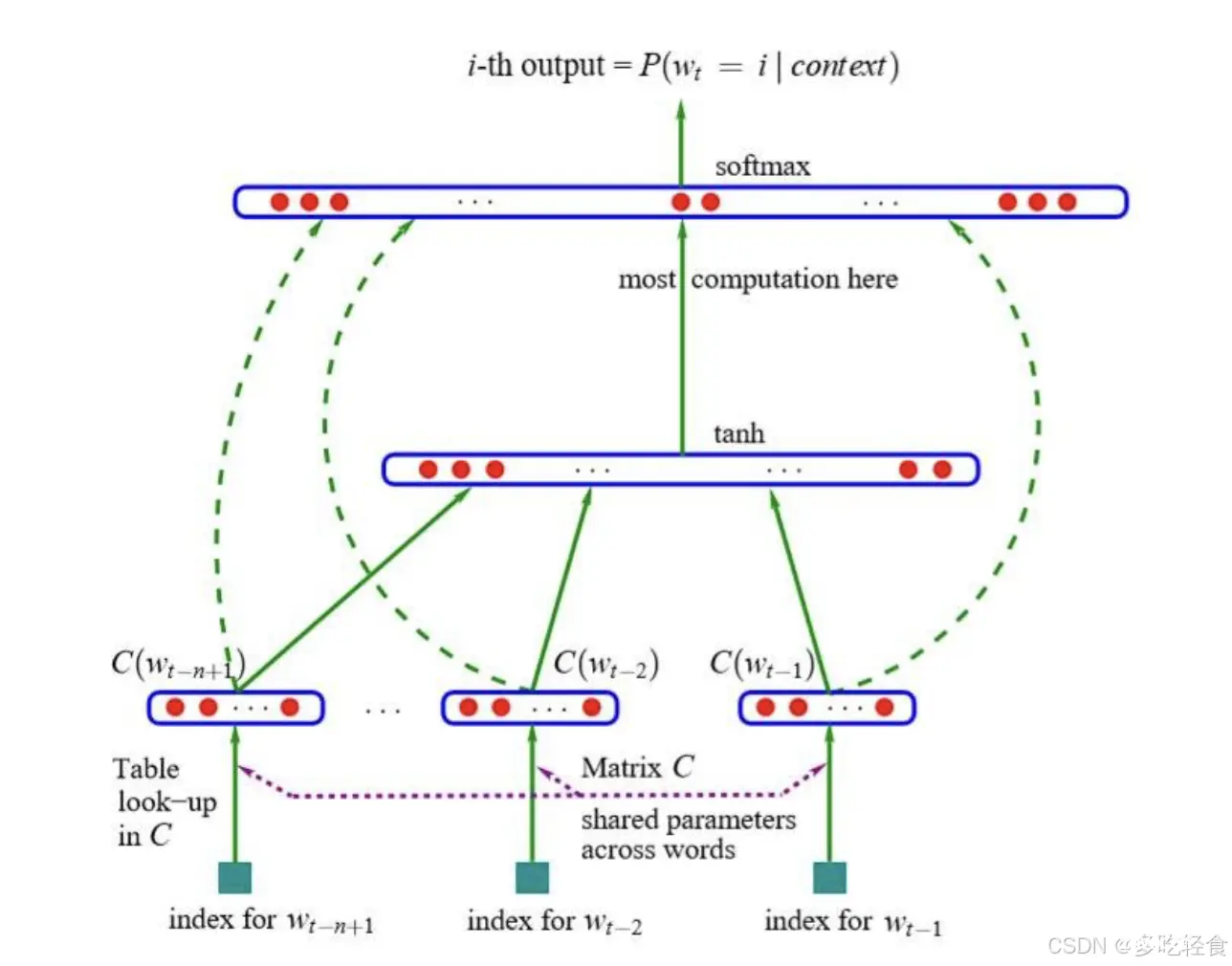

2003年的神经概率语言模型提出使用神经网络来学习单词之间的复杂关系,打破了传统统计语言模型的局限。

这一思想为后续的神经网络语言模型的发展奠定了坚实基础,是后续的神经网络语言模型(CNN, RNN, LSTM)的思想起点。

4.5Word2Vec

2013年出现的Word2Vec是一个重要的里程碑,是一种通过训练神经网络模型来学习词汇的分布式表示,简单高效。

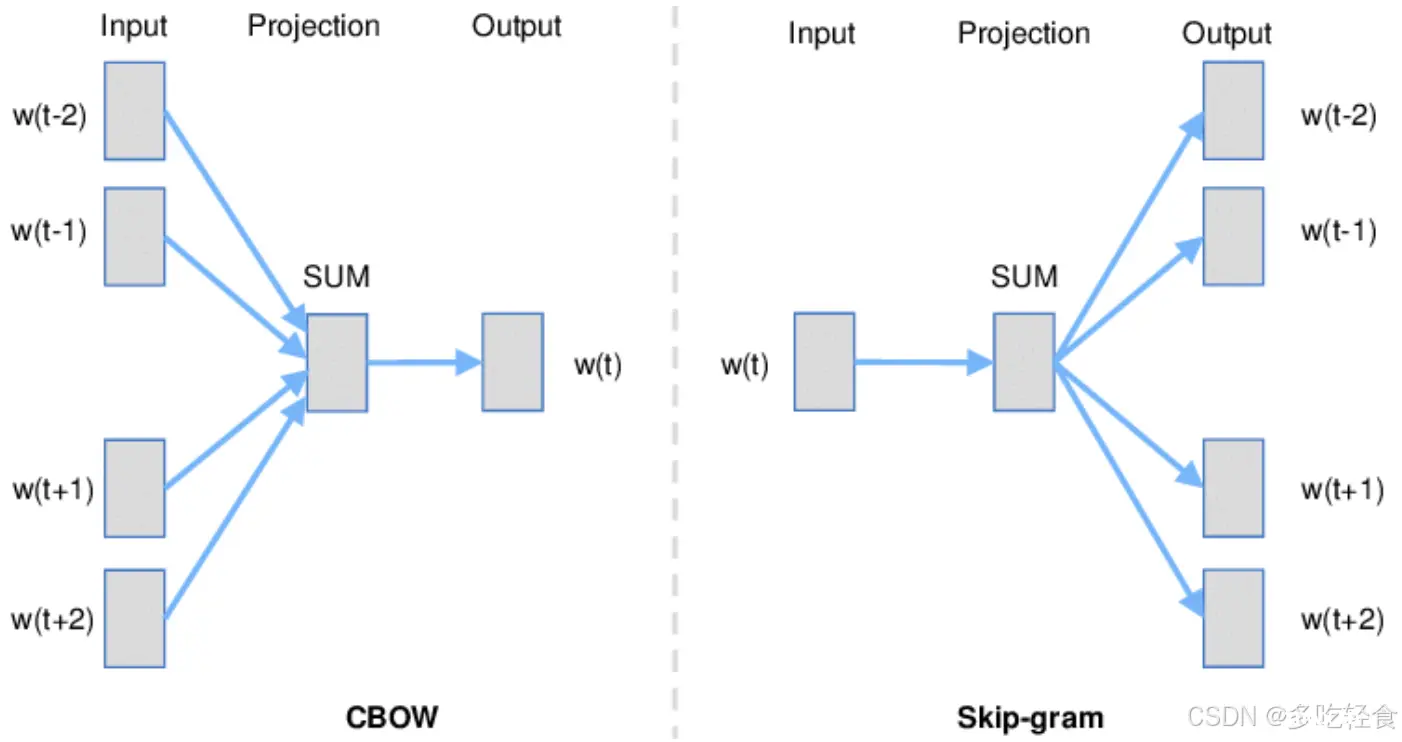

他有两种主要的架构:CBOW(Continuous Bag os Words)和Skim-Gram模型。

W2C生成的词向量可以捕捉到单词之间的相似性,语义关联及词汇的句法信息。他的思想和训练结果被广泛用于许多NLP模型中。

4.6预训练语言模型

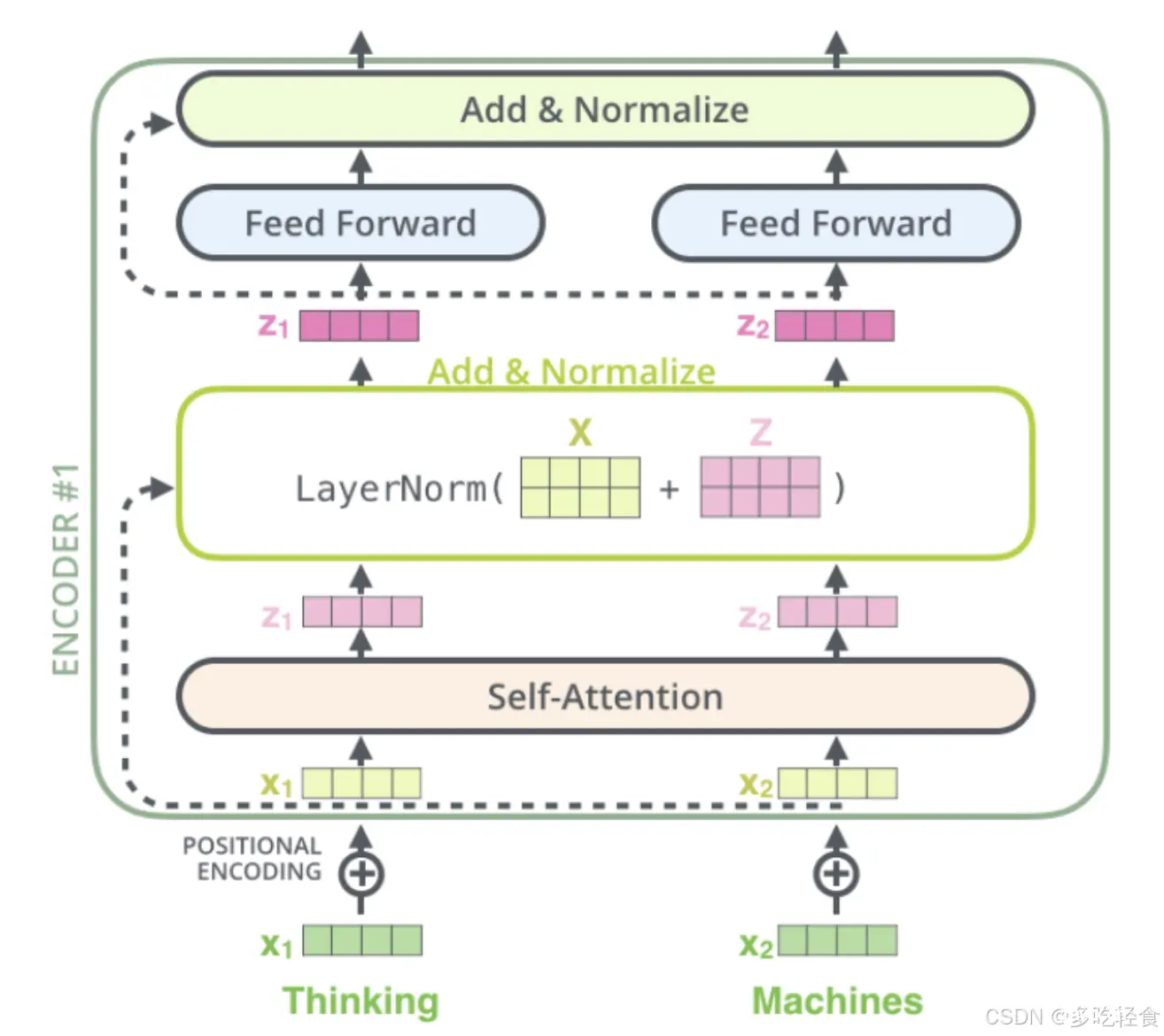

2018年后,基于Transformer的预训练语言模型一统江湖,在自然语言处理领域的许多任务的主导方法。

他通过更大的语料库和更加复杂的神经网络体系结构来进行语法和语义的信息学习,这就是语言模型的预训练过程。

这些模型的具体的NLP任务中(机器翻译、问答系统等)上进行微调后,表现的十分出色。并且不断刷新各大基准测试的SOTA(State Of The Art, 可以理解为某些领域的最高效果)。

图中的每个节点都为后续的技术诞生打下了基础,其关键点是从基于规则的模型到基于统计的模型的跃迁,以及海量的语料库训练出来的大模型的使用。

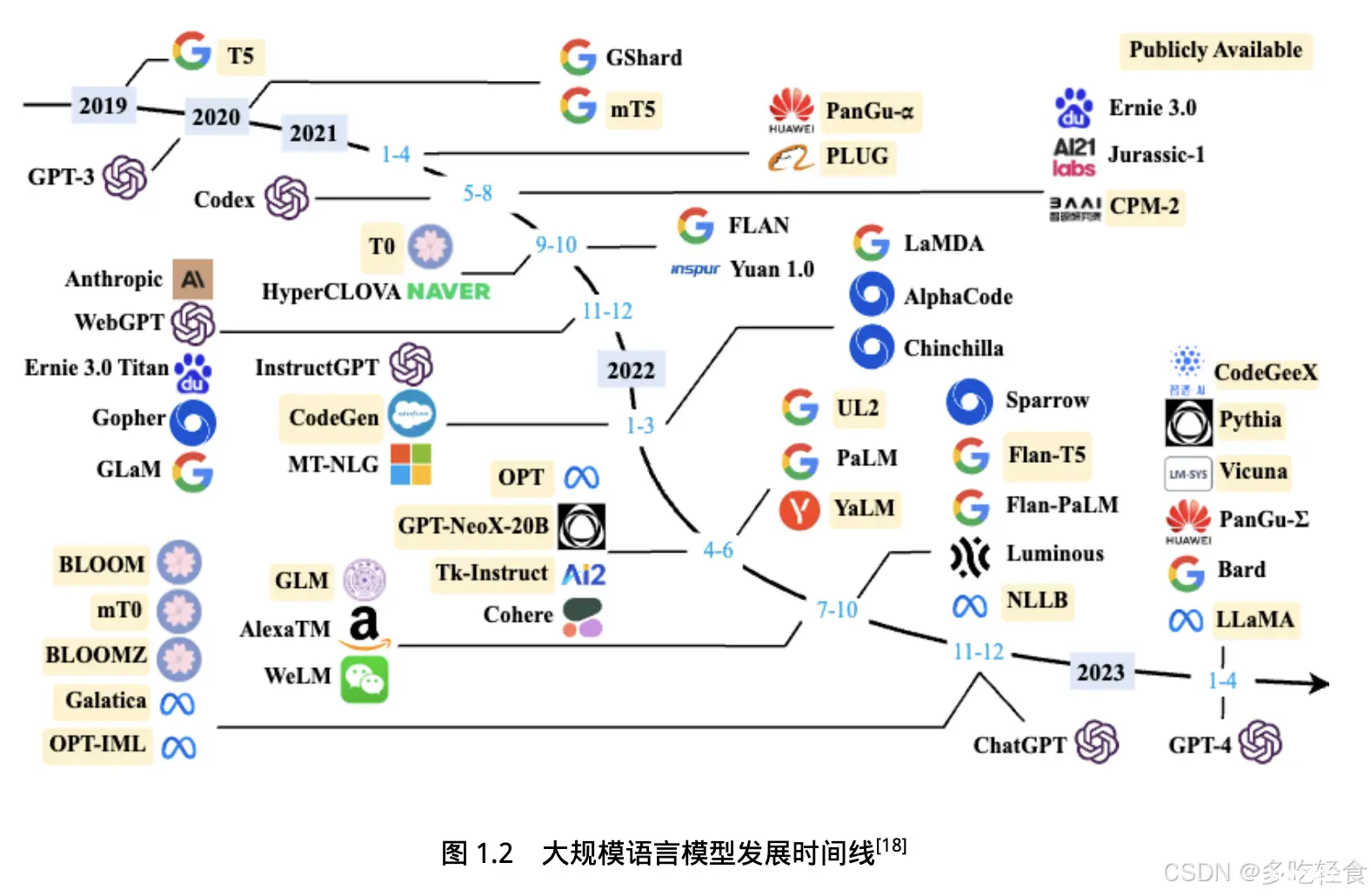

5.大模型时代的发展历史

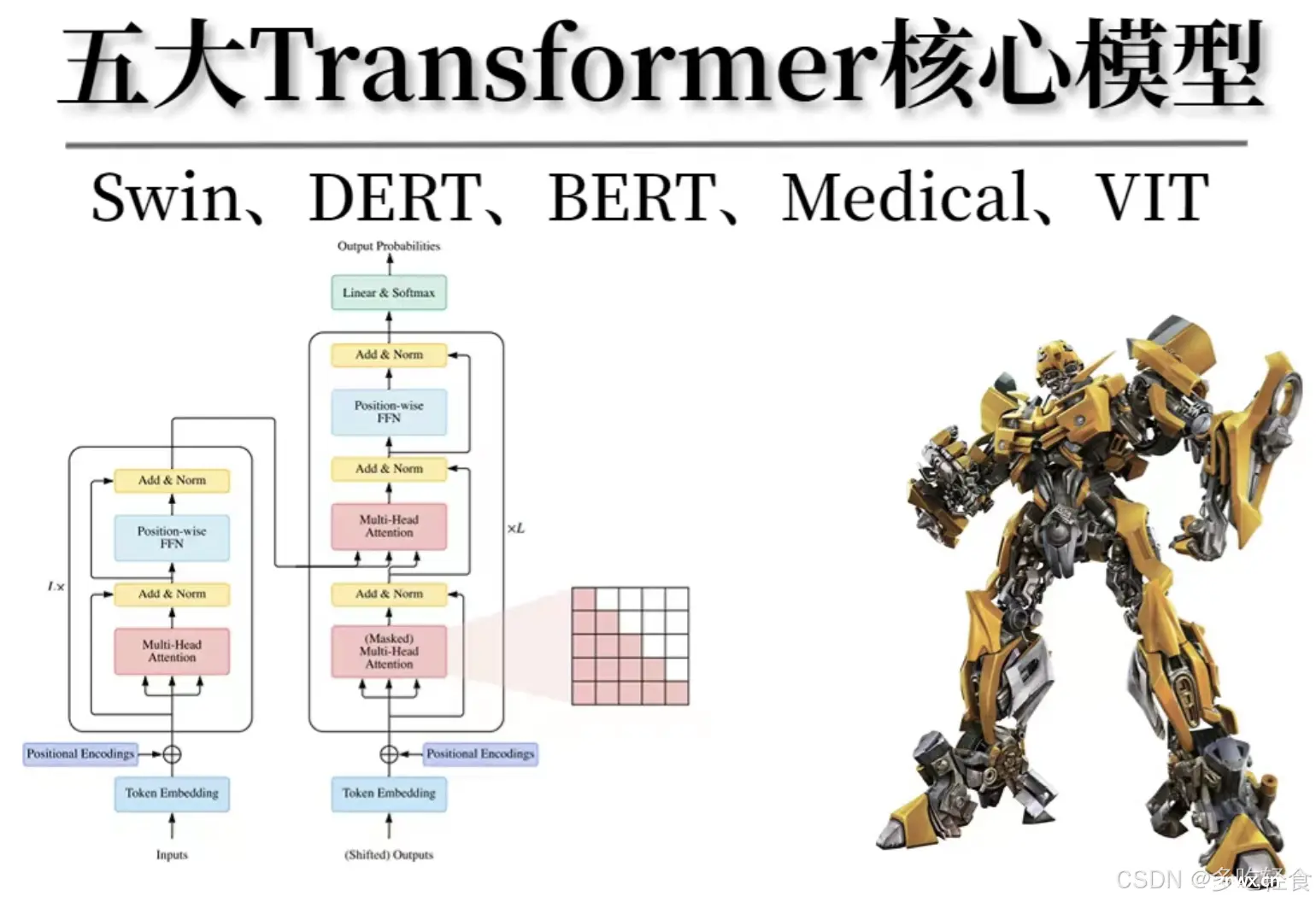

大模型时代的到来,彻底改变了NLP领域的发展路径,自2017年Transformer提出以来,NLP经历了基础模型阶段,能力探索阶段和突破爆发阶段,每个阶段都带来了显著的技术进步和应用创新。

5.1基础模型阶段

主要集中在2018年至2021年。2017 年瓦斯瓦尼(Vaswani)等人提出了 Transformer架构,在机器翻译任务上取得了突破性进展。

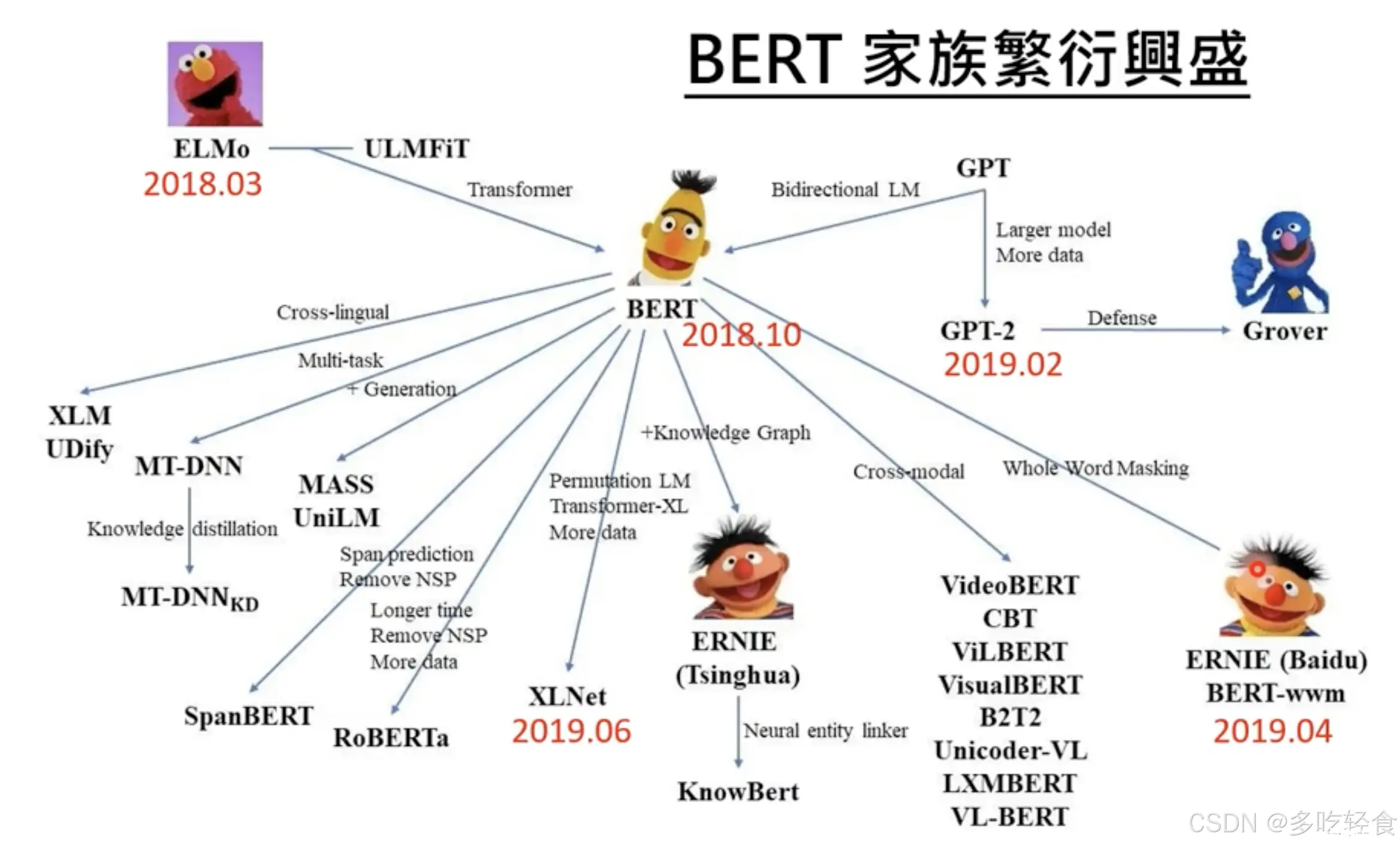

2018年 Google 和 Open AI 分别提出了BERT和GPT-1模型,开启了预训练语言模型时代。

经典的BERT系列模型,如下:

此后,国内也相继推出了一系列的大规模语言模型,包括清华大学 ERNIE(THU)、 百度 ERNIE(Baidu)、华为盘古-α等。

这个阶段研究主要集中语言模型本身,包括仅编码器(Encoder Only)、编码器-解码器(Encoder-Decoder)、仅解码器(Decoder Only)等各种类型的模型结构都有相应的研究。模型大小与BERT相类似的算法,通常采用预训练+微调范式,针对不同下游任务进行微调。但是模型参数量在10亿以上时,由于微调的计算量很高,这类模型的影响力 在当时相较 BERT 类模型有不小的差距

GPT系列:OpenAI的生成式预训练模型(GPT)系列包括GPT-1、GPT-2和GPT-3。GPT-1首次引入了生成式预训练(Generative Pretraining)和自回归模型架构,通过大规模语料库预训练,提升了生成文本的流畅性。GPT-2以15亿参数的规模震惊业界,展示了强大的生成能力。GPT-3更是将参数量提升至1750亿,显著增强了模型的通用性和理解能力。

BERT:谷歌提出的双向编码器表示(BERT)模型,通过Masked Language Model(MLM)和Next Sentence Prediction(NSP)任务进行预训练,实现了对上下文的深度理解。BERT在多个NLP任务上取得了突破性进展,广泛应用于问答系统、文本分类等领域。

ERNIE:清华大学提出的增强表示模型(ERNIE),通过引入知识图谱进行预训练,增强了模型对知识的理解和推理能力。ERNIE在多个中文NLP任务上表现优异,展示了知识增强预训练的潜力。

PANGU-

α

\alpha

α:华为推出的PANGU-

α

\alpha

α模型,通过超大规模参数和大规模语料库预训练,展示了强大的生成和理解能力。PANGU-

α

\alpha

α在多项中文任务中表现出色。

其他模型:这一时期还涌现了许多重要的模型,如ALBERT(参数共享和分解矩阵降低模型复杂度)、RoBERTa(通过更长时间预训练和更大数据集增强性能)、**ELECTRA(通过替换token检测任务提高预训练效率)**等。这些模型在预训练范式、模型结构和任务设计上进行了多种创新,解决了许多NLP领域的实际问题。

5.2能力探索阶段

能力探索阶段集中于2019年至2022年,由于大规模语言模型很难针对特定任务进行微调,研究人员们开始探索在不针对单一任务进行微调的情况下如何能够发挥大规模语言模型的能力。

2019年Radford 等人就使用GPT-2模型研究了大规模语言模型在零样本情况下的任务处理能力。在此基础上,Brown等人在GPT-3模型上研究了通过语境学习(In-Context Learning)进行少样本学习的方法。将不同任务的少量有标注的实例拼接到待分析的样本之前输入语言模型,使用语言模型根据实例理解任务并给出正确结果。

但是仅依赖基于语言模型本身,其性能在很多任务上仍然很难达到有监督学习效果,因此研究人员们提出了指令微调(Instruction Tuning)案,将大量各类型任务,统一为生成式自然语言理解框架,并构造训练语料进行微调。大规模语言模型一次性学习数千种任务,并在未知任务上展现出了很好的泛化能力。

这些方法从直接利用大规模语言模型进行零样本和少样本学习的基础上,逐渐扩展到利用生成式框架针对大量任务进行有监督微调的方法,有效提升了模型的性能。

几个概念–>

Zero-shot学习:大模型通过预训练阶段获取大量知识,在没有特定任务训练数据的情况下,也能完成任务。GPT-3在Zero-shot学习上的表现尤其出色,展示了强大的通用性。Few-shot学习:大模型在提供少量示例的情况下,能够快速适应新任务。通过在任务上下文中提供示例,大模型能够理解并完成特定任务,这一能力在GPT-3中得到了显著体现。指令微调:通过在预训练模型上进行指令式微调(Instruction Tuning),模型能够更好地理解和执行自然语言指令。指令微调大大提升了模型的实用性和用户交互体验。有监督微调与强化学习:结合有监督微调和强化学习技术,进一步提升模型在特定任务上的性能。例如,OpenAI的GPT-3通过有监督微调和PPO(Proximal Policy Optimization)强化学习策略,显著提高了对话生成质量。

5.3突破发展阶段

突破发展阶段以2022年11月的ChatGPT的发布为起点,大模型的发展进入了突破爆发阶段,大模型的数量和应用场景实现了爆发式增长。

ChatGPT的发布:2022年11月,OpenAI发布的ChatGPT引发了全球范围内对话式AI的热潮。ChatGPT基于GPT-3.5,通过大量对话数据进行微调,在自然语言理语境学习(In-Context Learning)进行少样本学习的方法。将不同任务的少量有标注的解和生成方面表现出色,成为了对话式AI的标杆。

模型数量爆发:随着技术的进步和算力的提升,各大科技公司和研究机构纷纷推出自己的大模型。Google的PaLM、Meta的OPT-175B、Microsoft的Turing-NLG等模型不断刷新参数规模和性能纪录。

多模态模型的崛起:不仅限于文本处理,多模态模型开始崭露头角,能够处理文本、图像、音频等多种数据类型,提升了模型的应用范围和能力。例如,OpenAI的DALL-E和CLIP在图像生成和理解方面取得了显著进展。

应用场景的扩展:大模型在各个领域的应用不断扩展,从医疗诊断、法律咨询到教育培训,均展示了强大的应用潜力。大模型在实际应用中的表现和价值得到了广泛认可。

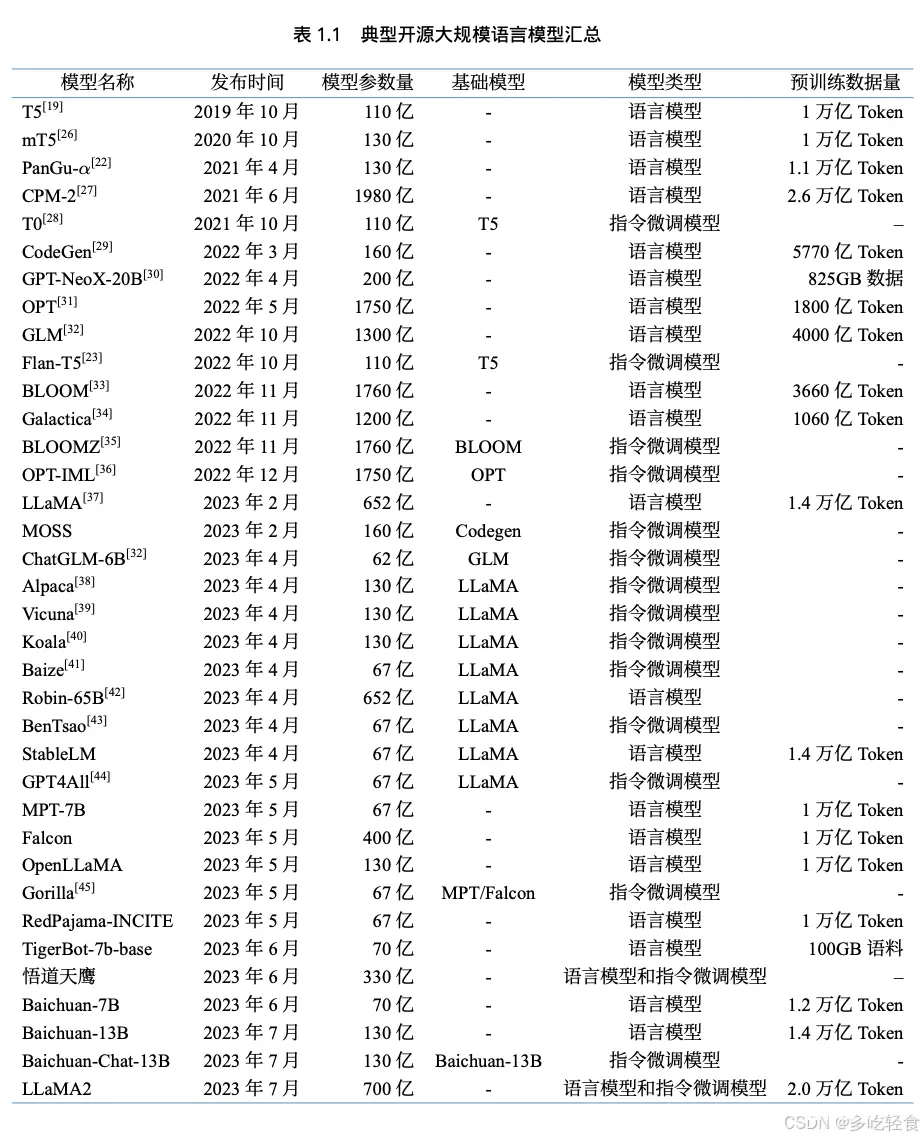

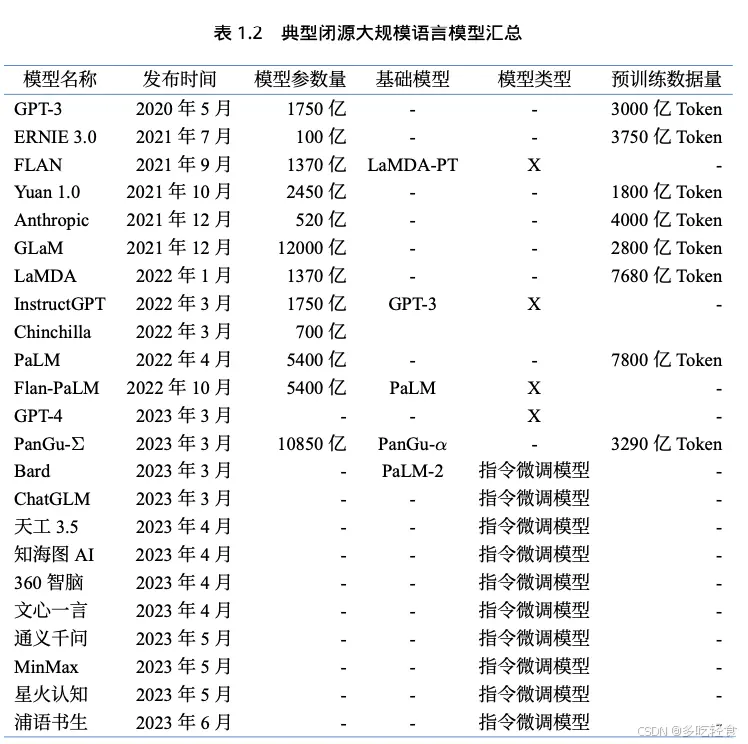

下面是一些典型的开源和闭源大模型汇总:

结尾

回顾人工智能及其关键分支的发展历程,我们不禁为人类智慧的伟大和技术的力量所震撼。从最初的梦想与探索,到如今的广泛应用与深刻影响,人工智能不仅改变了我们的生活方式和工作模式,更引领着人类社会迈向了一个全新的智能时代。

然而,我们也应清醒地认识到,人工智能的发展仍面临诸多挑战和未知。如何确保技术的安全可控、如何促进人机和谐共生、如何避免技术滥用和伦理风险……这些问题都需要我们共同思考和努力解决。

展望未来,我们有理由相信,随着技术的不断进步和应用的不断深化,人工智能将在更多领域发挥更大的作用和价值。它将成为推动社会进步的重要力量,为人类创造更加美好的明天。让我们携手并进,共同迎接这个充满机遇与挑战的智能时代吧!

参考资料

《神经网络与深度学习》 - 邱锡朋

《百面机器学习》 - 诸葛越

《GPT图解》 - 黄佳

《预训练语言模型》 - 邵浩

《大规模语言模型》 - 张齐

声明

本文内容仅代表作者观点,或转载于其他网站,本站不以此文作为商业用途

如有涉及侵权,请联系本站进行删除

转载本站原创文章,请注明来源及作者。